求助:Call to localhost/127.0.0.1:9000 failed on connection exception

最近在用hadoop实现kmeans。

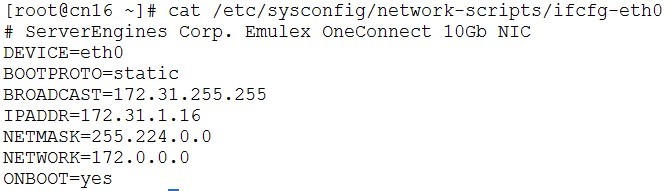

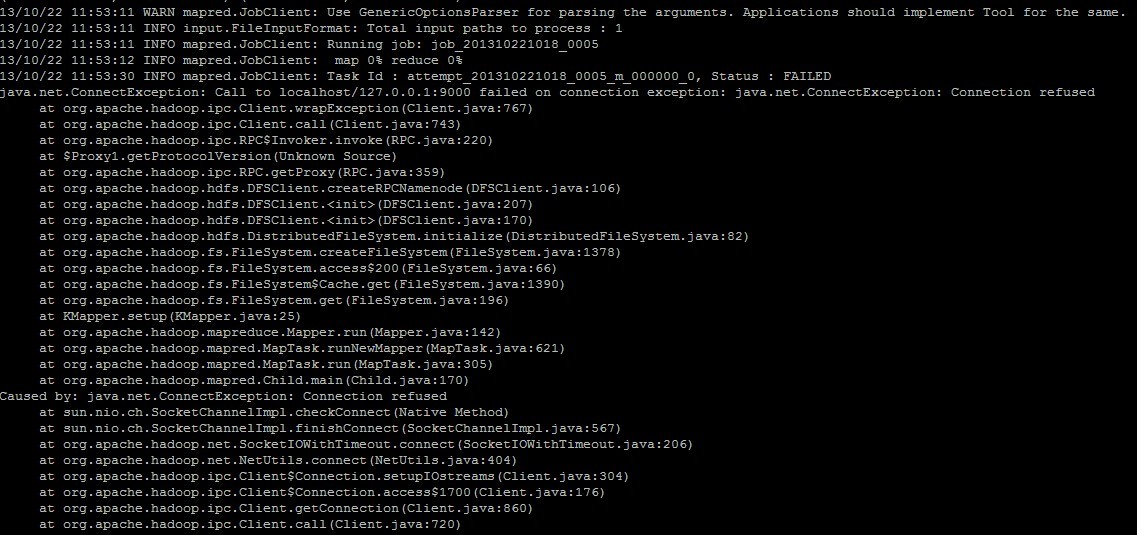

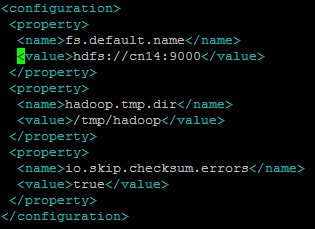

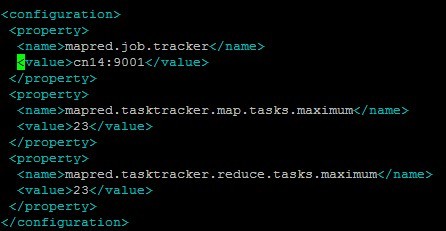

运行过程中出现Call to localhost/127.0.0.1:9000 failed on connection exception错误。

百度和google了一下,貌似很多人都遇到过这个问题,好像大部分人都是namenode 启动不正常导致的,重新格式化namenode之后能解决,但是,我格式化了无数遍了还是出现这个错误,别的方法也试了,都不管用,实在不知道怎么解决了

有没有遇到这个问题的大侠解决一下啊

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享