最近在学习使用ceph做openstack的块存储后端,ceph集群已经部署完毕了,2个osd,一个monitor。

主要需求就是需要ceph能够为openstack提供一个云硬盘即可!

下面是集群状态:

root@compute1:/var/lib/ceph/osd# ceph -s

cluster 03b6e784-8076-4814-88d4-52c3d3e45c1e

health HEALTH_OK

monmap e1: 1 mons at {compute=172.16.1.230:6789/0}, election epoch 1, quorum 0 compute

osdmap e12: 2 osds: 2 up, 2 in

pgmap v101: 320 pgs, 4 pools, 197 MB data, 65 objects

10699 MB used, 30238 MB / 40938 MB avail

320 active+clean

然后再openstack的cinder-volume节点上配置使用多存储后端,下面是配置/etc/cinder/cinder.conf文件的部分内容:

...

[default]

enabled_backends=lvm230,ceph-test //使能多存储后端

[lvm230] //LVM配置组

volume_group=compute-vg

volume_driver=cinder.volume.drivers.lvm.LVMISCSIDriver

volume_backend_name=lvm230

[ceph-test] //ceph rbd 配置组

volume_backend_name=ceph-test

volume_driver = cinder.volume.drivers.rbd.RBDDriver

rbd_pool = volumes

rbd_ceph_conf = /etc/ceph/ceph.conf

rbd_flatten_volume_from_snapshot = false

rbd_max_clone_depth = 5

rbd_store_chunk_size = 4

rados_connect_timeout = -1

...

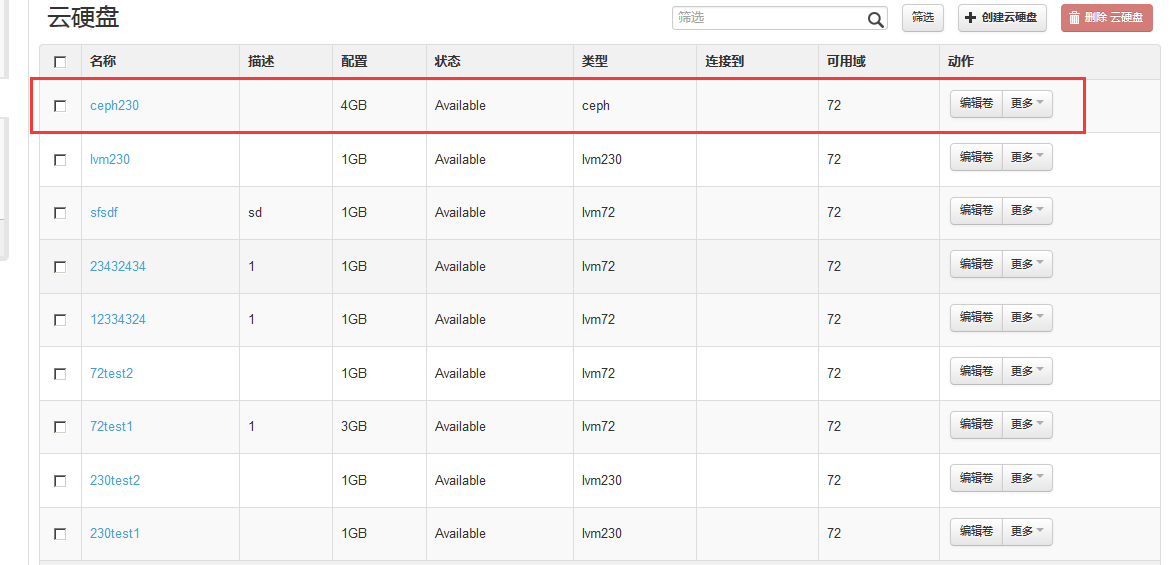

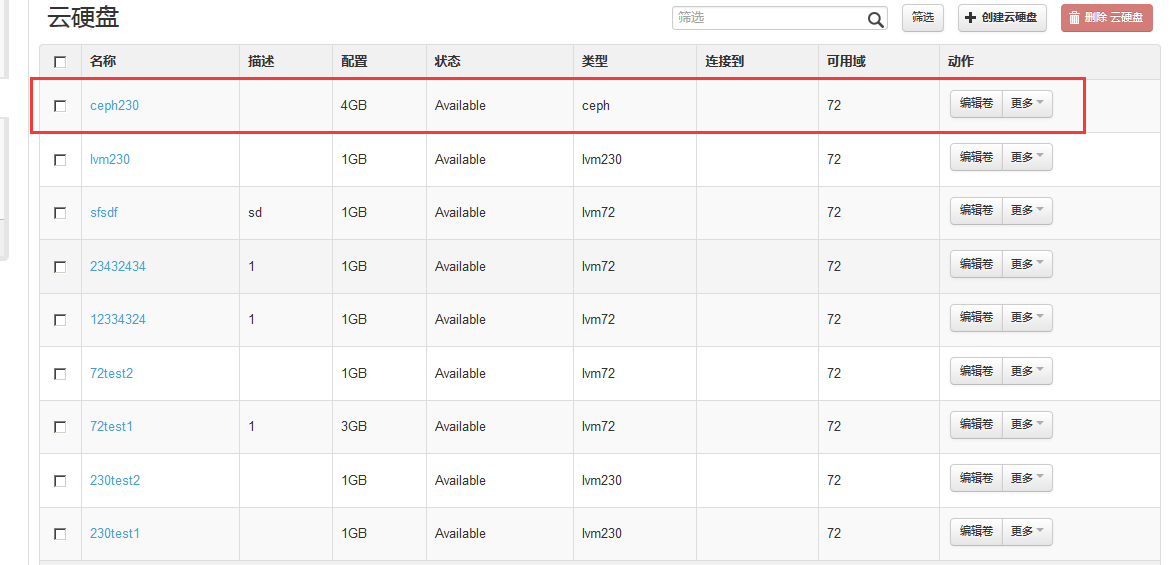

然后,我就去界面创建云硬盘,界面上可以看出云硬盘已经可以使用了,本以为到这就成功了。。。

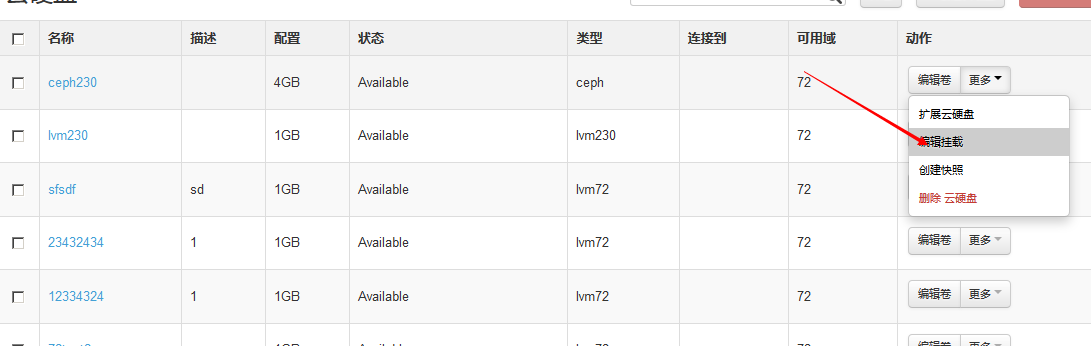

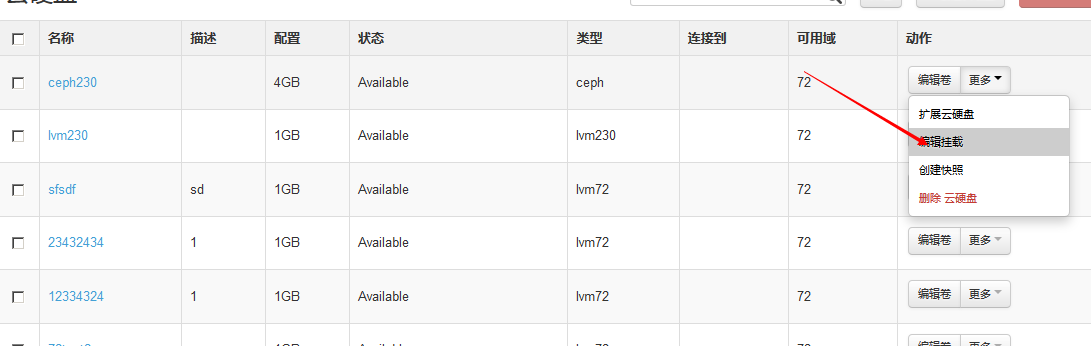

然后去编辑挂载它到一台虚拟机,却没有任何反应:

查看日志:

主要的一条就是

DeviceIsBusy: The supplied device (vdb) is busy.

提示我要挂载的那台虚机的/dev/vdb是忙的,但是我用其他的云硬盘挂载到这台虚机是没问题的。。。

所以问题应该还是出在ceph这边。。。

不知大家是否遇到过这样的问题,还望高手不吝赐教,信息贴的有限,如果有需要,我可以再追加更为详细的配置情况!

只求解决问题!

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享