python自动执行往数据库中insert into 数据,遇到Invalid session id,什么原因?

墨小月大大 2017-07-21 09:41:10

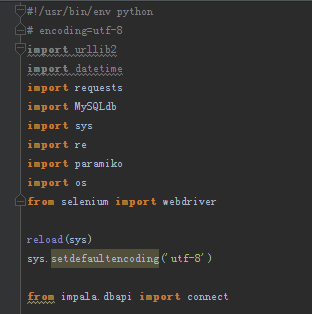

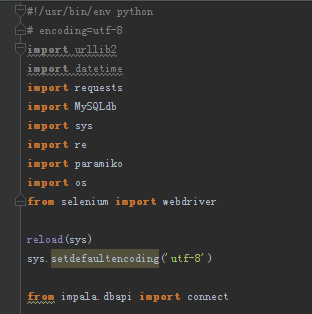

墨小月大大 2017-07-21 09:41:10 [size=14px]执行脚本

insert into webpower_core_db.url_path(click_name, url, source_path, content_path, client_name, mailingid)

VALUES ('%s','%s','%s','%s','%s','%s')

一共是11万条,让它自动执行一晚上,昨晚看的时候还是正常的,早晨起来一看,只插入了1142条,其他的插入信息,都显示: Invalid session id

求助求助,啥原因???大神指导下。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享