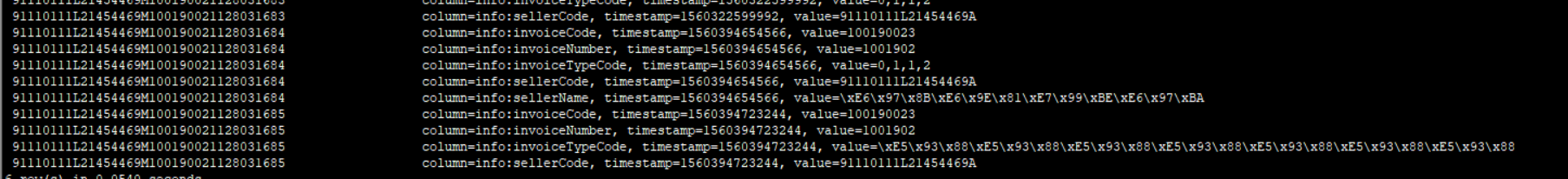

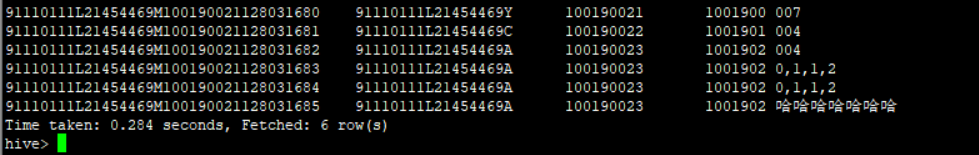

hbase 查询的值为汉字,显示的是16进制的,不是汉字本身

比如汉字为 王洋

hbase(main):001:0> get 'dw_tbl:crm_user_info', '000001'

COLUMN CELL

base:cust_age timestamp=1513061969519, value=29

base:cust_id timestamp=1513061868747, value=000001

base:cust_name timestamp=1513065649903, value=\xE7\x8E\x8B\xE6\xB4\x8B

通过什么样的操作能显示为

hbase(main):001:0> get 'dw_tbl:crm_user_info', '000001'

COLUMN CELL

base:cust_age timestamp=1513061969519, value=29

base:cust_id timestamp=1513061868747, value=000001

base:cust_name timestamp=1513065649903, value=王洋

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享