57,062

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享

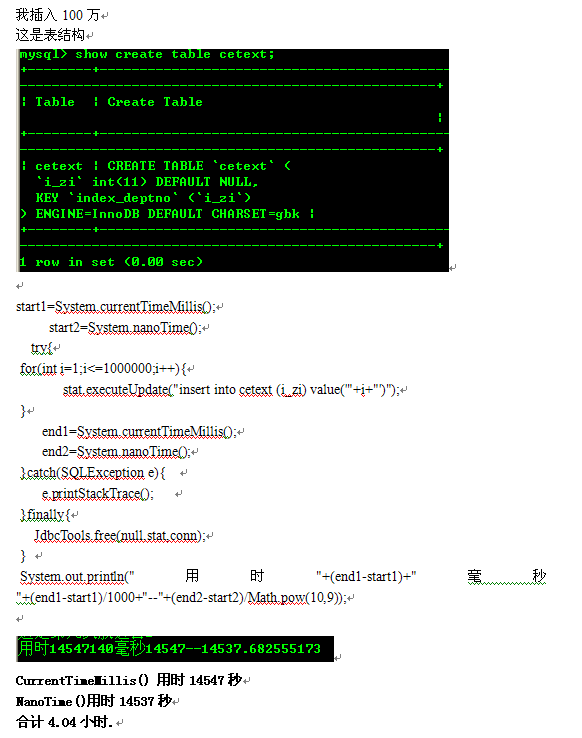

sql=insert into cetext(i_zi) value(?)

PreparedStatement pstmt = conn.prepareStatement(sql);

for (int i=0;i<1000000;i++){

pstmt.setInt(1,i);

pstmt.addBatch();

if (i%200==0){ //每200条执行一次,可以缓解mysql的压力

pstmt.executeBatch()

}

}