问题:hadoop2.5.1,启动主节点的datanode,无法自动启动 slaves的datanode服务,可以到slave的机器手机启动 datanode。

环境:

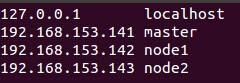

三台虚拟机,系统ubuntu,ip(主机名)分别为: 192.168.153.141(master)、192.168.153.142(node1)、192.168.153.143(node2)

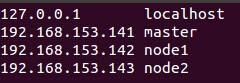

/etc/hosts 配置:

192.168.153.141 master

192.168.153.142 node1

192.168.153.143 node2

ssh都已安装且可无密码登录。

hadoop相关配置:

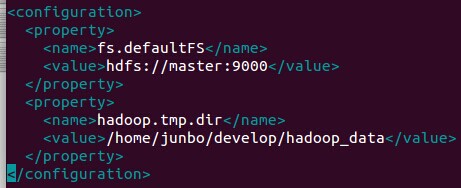

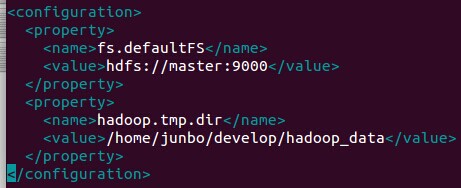

core-site.xml

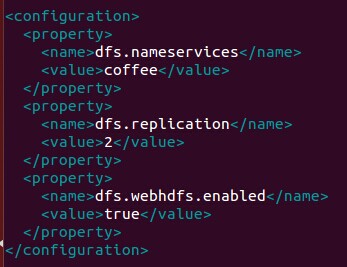

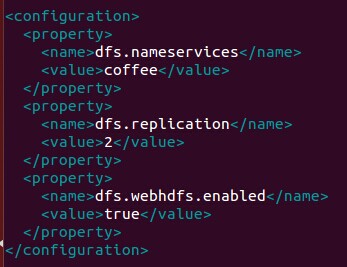

hdfs-site.xml

hdfs-site.xml

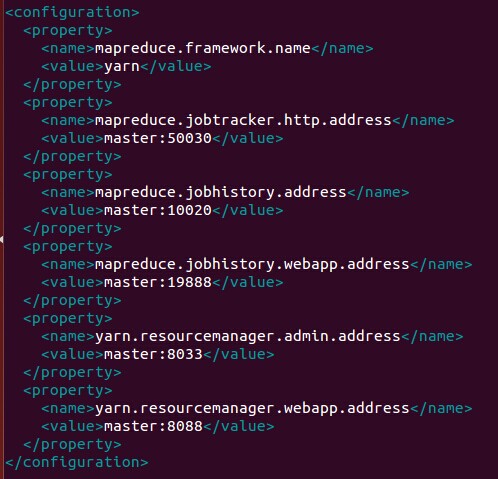

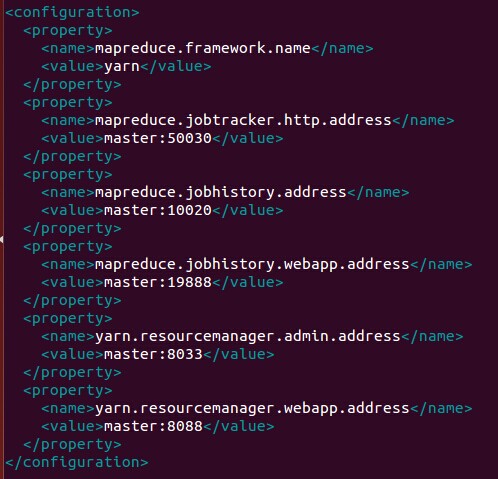

mapred-site.xml

mapred-site.xml

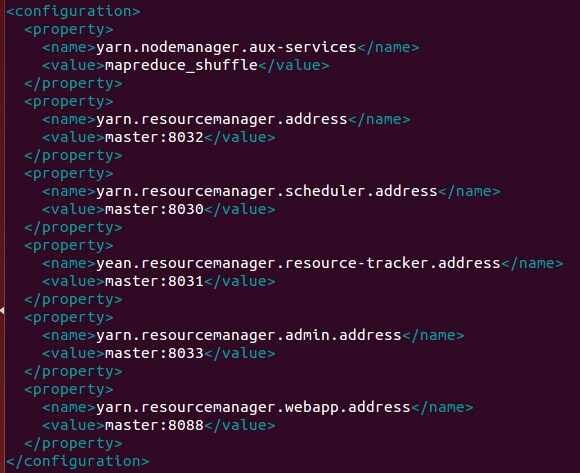

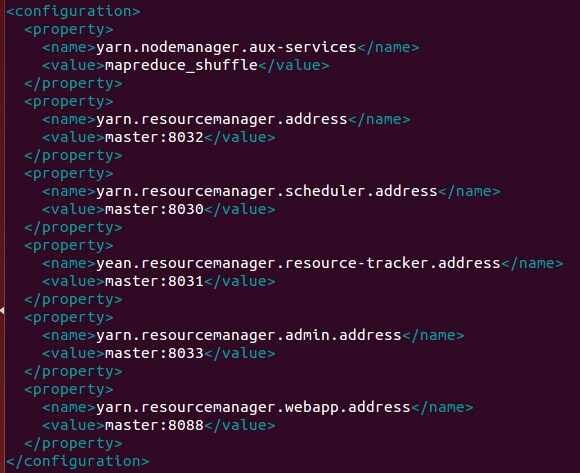

yarn-site.xml

yarn-site.xml

slaves配置:

slaves配置:

master机器通过 ${HADOOP_HOME}/sbin/hadoop-daemon.sh --script hdfs start namenode 启动namenode成功,可成功打开 http://master:50070。

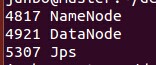

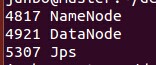

master机器通过 ${HADOOP_HOME}/sbin/hadoop-daemon.sh --script hdfs start datanode启动datanode成功,输入jps命令如下:

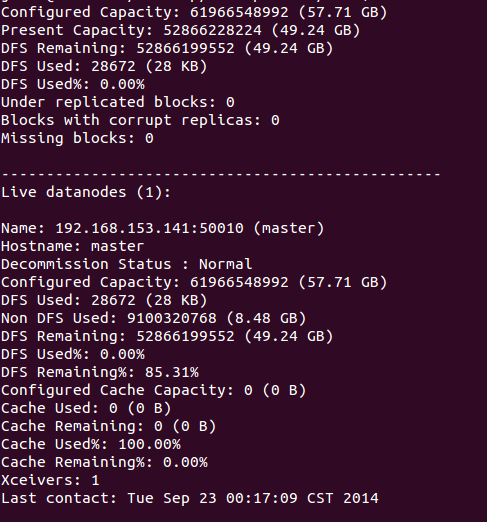

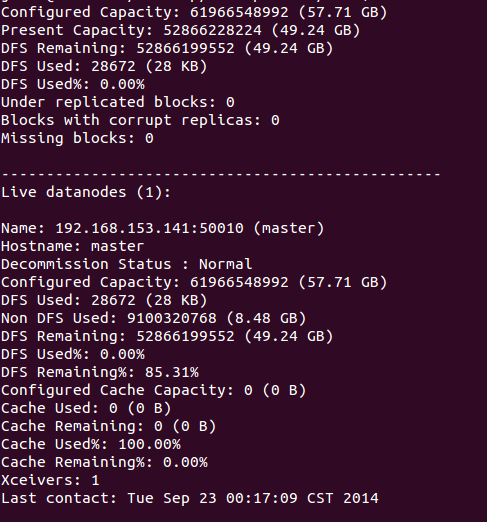

输入 hdfs dfsadmin -report如下:

。

进入 node1或node2机器,输入jps命令没有发现datanode,按官网说是可以自动启动 slaves机器上的datanode的,或者是我理解错误?请指教。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享

。

。