查询速度很慢,查询语句如下:

SELECT

a.stockid ,

b.freq ,

d.vwap ,

a.exdate,

a.comp ,

c.methodid - 6000000 ,

c.nums ,

c.nums * b.freq / 100

FROM

ana a,

credit b,

result c,

source d

WHERE

a.exdate = '2016-04-15'

AND a.comp = b.comp

AND b.willarise > 0

AND c.methodid = b.methodid

AND c.comp = b.comp

AND d.qtid = a.stockid

AND d.date = a.exdate

ORDER BY b.freq;

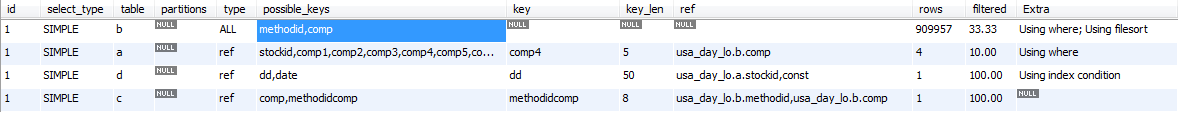

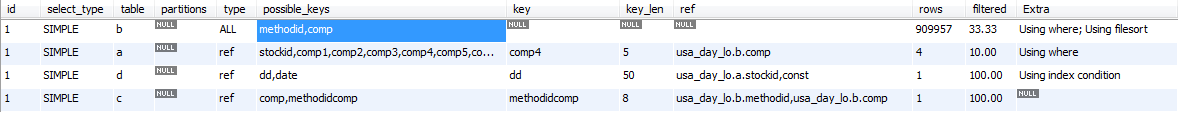

explain的结果如下:

各个表的情况如下:

b表比较小,96万多点,索引:

PRIMARY KEY (`sid`),

UNIQUE KEY `methodid` (`methodid`,`comp`) USING BTREE,

KEY `comp` (`comp`) USING BTREE

a,d,都是2300多万条数据,

a表索引:

PRIMARY KEY (`sid`),

UNIQUE KEY `stockid` (`stockid`,`exdate`) USING BTREE,

KEY `iddate` (`sid`,`stockid`,`exdate`) USING BTREE,

KEY `comp1` (`comp`,`arise1`) USING BTREE,

KEY `comp2` (`comp`,`arise2`) USING BTREE,

KEY `comp3` (`comp`,`arise3`) USING BTREE,

KEY `comp4` (`comp`,`arise4`) USING BTREE,

KEY `comp5` (`comp`,`arise5`) USING BTREE,

KEY `comp6` (`comp`,`arise6`) USING BTREE,

KEY `comp7` (`comp`,`arise7`) USING BTREE,

KEY `comp8` (`comp`,`arise8`) USING BTREE,

KEY `comp9` (`comp`,`arise9`) USING BTREE,

KEY `comp10` (`comp`,`arise10`) USING BTREE,

d表的索引:

PRIMARY KEY (`sid`),

KEY `dd` (`qtid`,`date`,`volume`,`value`) USING BTREE,

KEY `date` (`date`) USING BTREE,

KEY `sss` (`sid`,`date`,`volume`,`vwap`) USING BTREE

c表,5000万出头,索引:

PRIMARY KEY (`sid`),

KEY `comp` (`comp`) USING BTREE,

KEY `numsgt0` (`nums`,`gt0`) USING BTREE,

KEY `methodidcomp` (`methodid`,`comp`) USING BTREE

本人不擅长SQL,请高手帮忙优化一下。机器性能不错,插入能每秒4万条左右。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享