37,720

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享

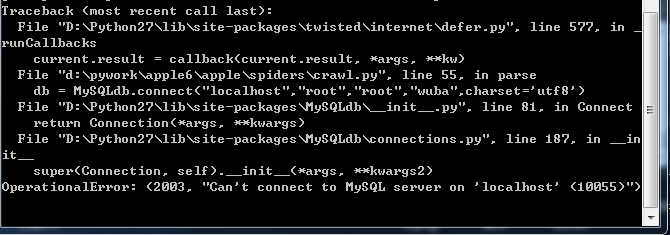

Traceback (most recent call last):

File "D:\Python27\lib\site-packages\twisted\internet\defer.py", line 577, in _

runCallbacks

current.result = callback(current.result, *args, **kw)

File "d:\pywork\apple6\apple\spiders\crawl.py", line 55, in parse

db = MySQLdb.connect("localhost","root","root","wuba",charset='utf8')

File "D:\Python27\lib\site-packages\MySQLdb\__init__.py", line 81, in Connect

return Connection(*args, **kwargs)

File "D:\Python27\lib\site-packages\MySQLdb\connections.py", line 187, in __in

it__

super(Connection, self).__init__(*args, **kwargs2)

OperationalError: (2003, "Can't connect to MySQL server on 'localhost' (10055)")