34,576

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享

看不懂什么有价值的东西啊[/quote]

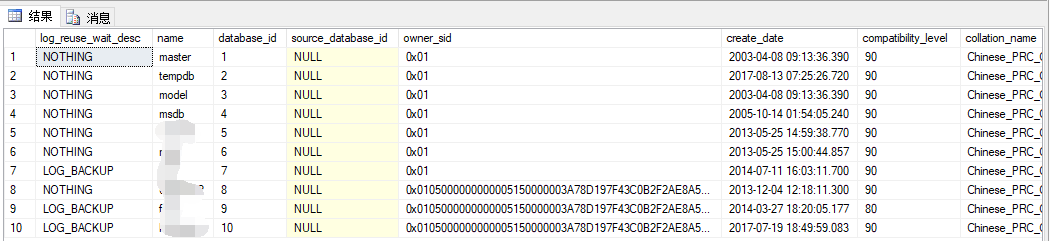

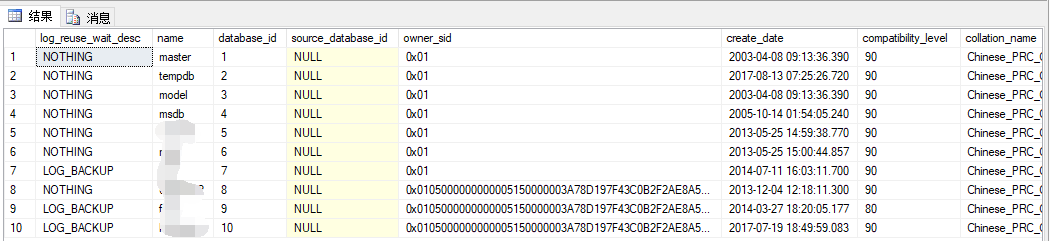

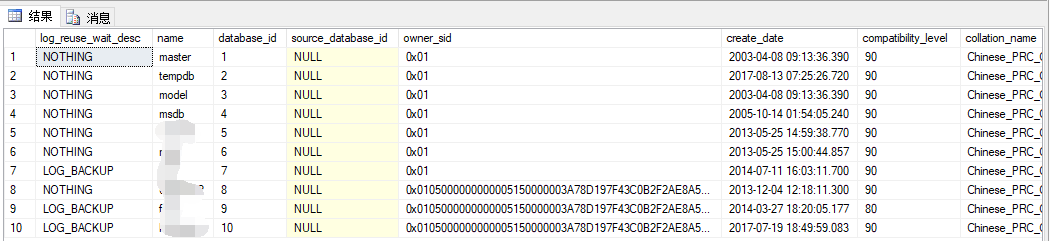

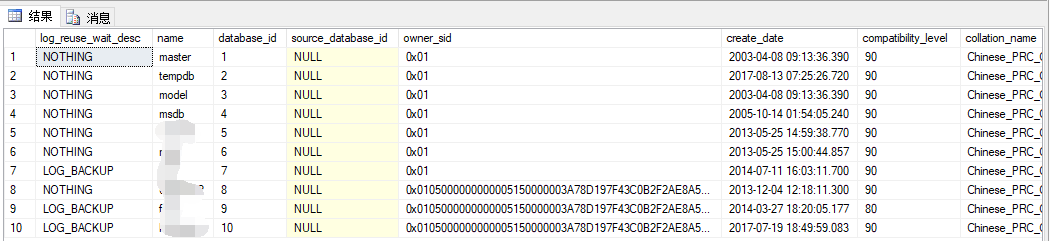

哪一行是你日志很大那个库[/quote]

最后一个哦[/quote]

可以参考下下面的博客:

http://blog.csdn.net/z10843087/article/details/77986055

你这个数据库对数据做下日志备份,日志就可以收缩了。如果想要日志自动变小,不要长的,你可以吧日志备份的频率增加。

比如现在1个小时一次,你改成15分钟一次。这样,日志就不会继续长大了。

看不懂什么有价值的东西啊[/quote]

哪一行是你日志很大那个库[/quote]

最后一个哦[/quote]

可以参考下下面的博客:

http://blog.csdn.net/z10843087/article/details/77986055

你这个数据库对数据做下日志备份,日志就可以收缩了。如果想要日志自动变小,不要长的,你可以吧日志备份的频率增加。

比如现在1个小时一次,你改成15分钟一次。这样,日志就不会继续长大了。

看不懂什么有价值的东西啊[/quote]

哪一行是你日志很大那个库[/quote]

最后一个哦

看不懂什么有价值的东西啊[/quote]

哪一行是你日志很大那个库[/quote]

最后一个哦SELECT d.name,d.log_reuse_wait_desc FROM sys.databases AS d WHERE d.name=DB_NAME() 看不懂什么有价值的东西啊[/quote]

哪一行是你日志很大那个库

看不懂什么有价值的东西啊[/quote]

哪一行是你日志很大那个库SELECT d.name,d.log_reuse_wait_desc FROM sys.databases AS d WHERE d.name=DB_NAME()