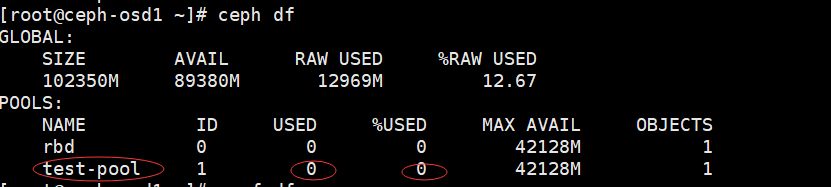

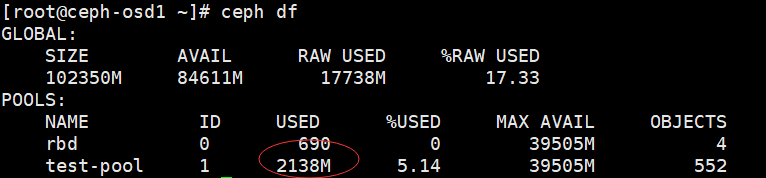

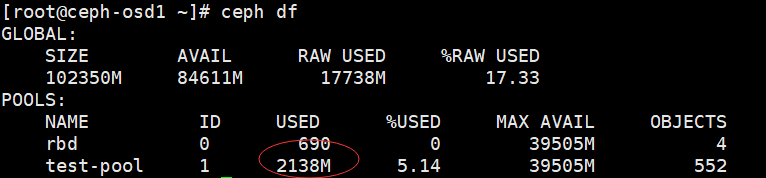

背景:已搭好Ceph集群(1Mon+ 2OSD),共有两个pool(rbd和test-pool),每个POOL的容量均为40G,如下图:

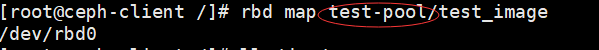

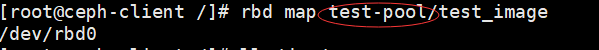

1.在Ceph-Client端基于test-pool创建test_image镜像,并map成功:

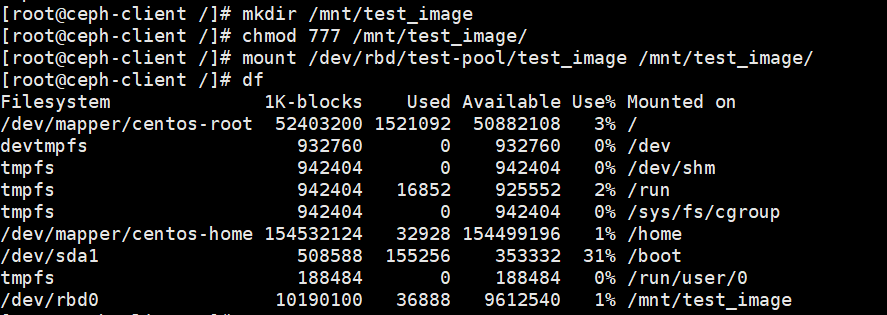

2.对test-image镜像进行文件系统格式化:

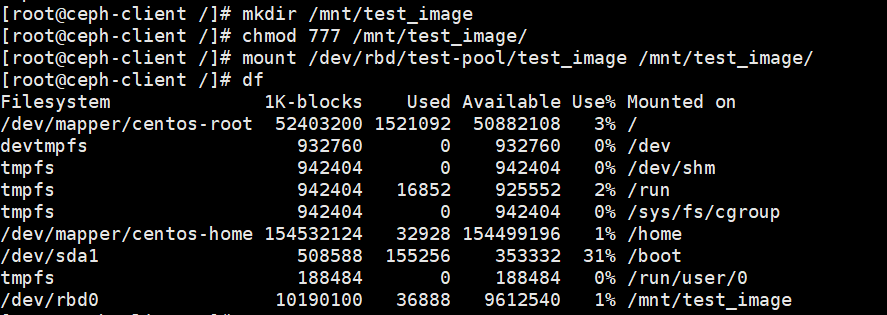

3.挂载块设备:

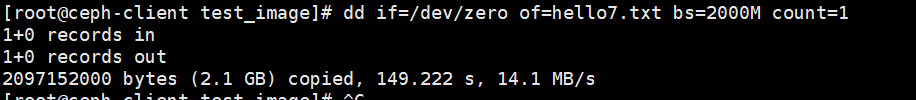

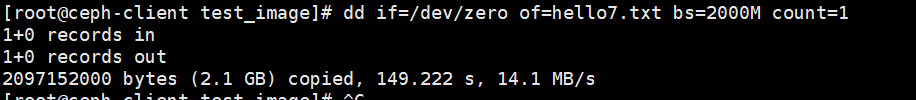

4.利用dd命令进行写操作(向/dev/rbd0写入2000M数据):

dd if=/dev/zero of=hello7.txt bs=2000M count=1

5.在Mon节点上查看test-pool的使用情况,表明已经写入了2000M:

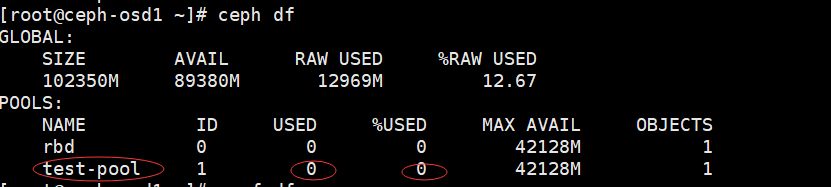

6.最后在ceph-client端删除之前dd写入的hello7.txt,但是ceph df显示test-pool的容量还是2000M:

Ceph客户端删除2000M的数据,为何Ceph df显示的已用容量没有变化呢? 望各位大神指教!

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享