20,808

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享 ,我查阅了一些资料,但资源配置这块还是不太确定。

我的spark集群配置如下:集群一共6个节点,每个节点给spark分配的内存是8G内存,每个节点分配4个CPU core。启动sparksql时:命令如下:

spark-sql --master spark://ip:7077 --executor-memory 4g --num-executors 2 --executor-cores 2

这样写意思是不是就是spark下每个节点有两个executor,每个executor有4g内存和2个CPU core,所以spark集群一共有12个executor。这样配置对吗?

还有就是spark.sql.shuffle.partitions参数设置的问题,这个值默认为200,资料说这个值设置的一般偏小,我需要修改吗?

求大哥解答下

,我查阅了一些资料,但资源配置这块还是不太确定。

我的spark集群配置如下:集群一共6个节点,每个节点给spark分配的内存是8G内存,每个节点分配4个CPU core。启动sparksql时:命令如下:

spark-sql --master spark://ip:7077 --executor-memory 4g --num-executors 2 --executor-cores 2

这样写意思是不是就是spark下每个节点有两个executor,每个executor有4g内存和2个CPU core,所以spark集群一共有12个executor。这样配置对吗?

还有就是spark.sql.shuffle.partitions参数设置的问题,这个值默认为200,资料说这个值设置的一般偏小,我需要修改吗?

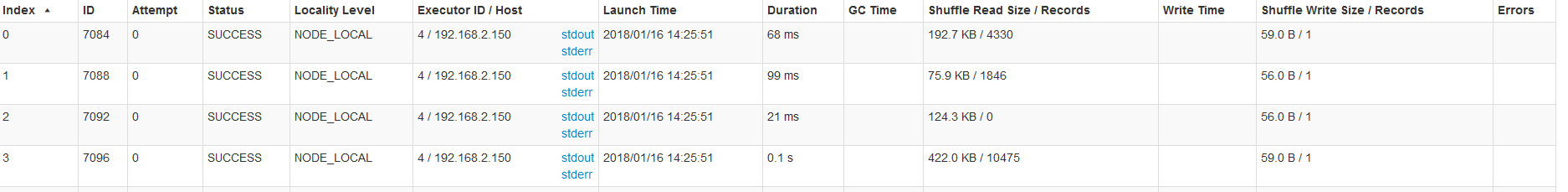

求大哥解答下 图片在这呢

图片在这呢