我的配置如下:

a1.channels = c1

a1.sinks = k1

#定义kafka-channel

a1.channels.c1.type = org.apache.flume.channel.kafka.KafkaChannel

a1.channels.c1.parseAsFlumeEvent = false

a1.channels.c1.kafka.bootstrap.servers = slave1:9092,slave3:9092,slave4:9092

a1.channels.c1.kafka.topic = incharge

a1.channels.c1.kafka.consumer.group.id = g101

#具体定义sink

a1.sinks.k1.type = hdfs

a1.sinks.k1.hdfs.path = hdfs://master:9000/gamelog/%Y%m%d

a1.sinks.k1.hdfs.useLocalTimeStamp = true

a1.sinks.k1.hdfs.filePrefix = log-

a1.sinks.k1.hdfs.fileType = DataStream

#不按照条数生成文件

a1.sinks.k1.hdfs.rollCount = 0

#HDFS上的文件达到128M时生成一个文件

a1.sinks.k1.hdfs.rollSize = 134217728

#HDFS上的文件达到60秒生成一个文件

a1.sinks.k1.hdfs.rollInterval = 60

a1.sinks.k1.channel = c1

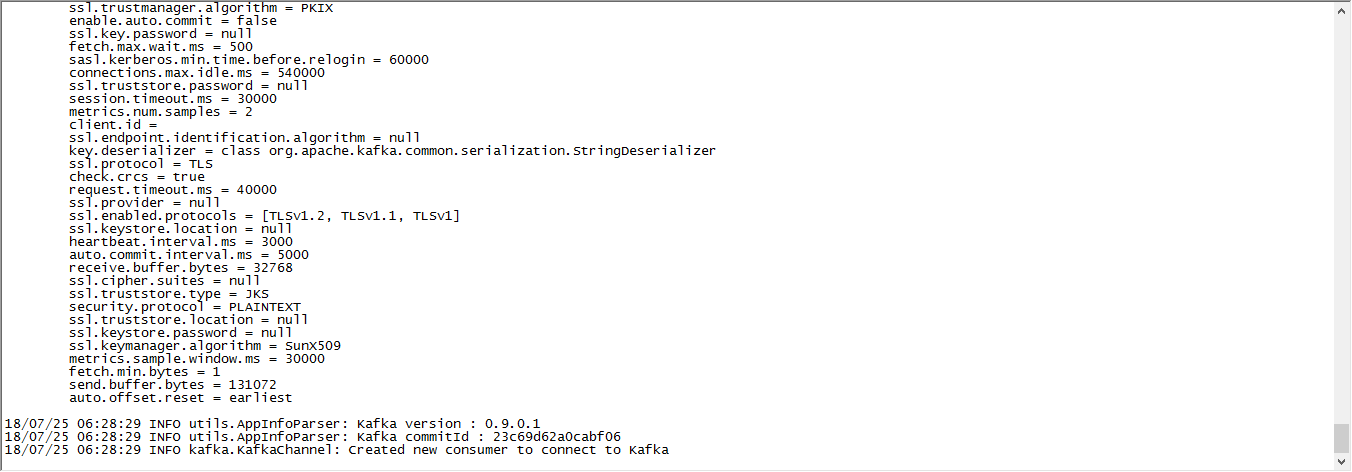

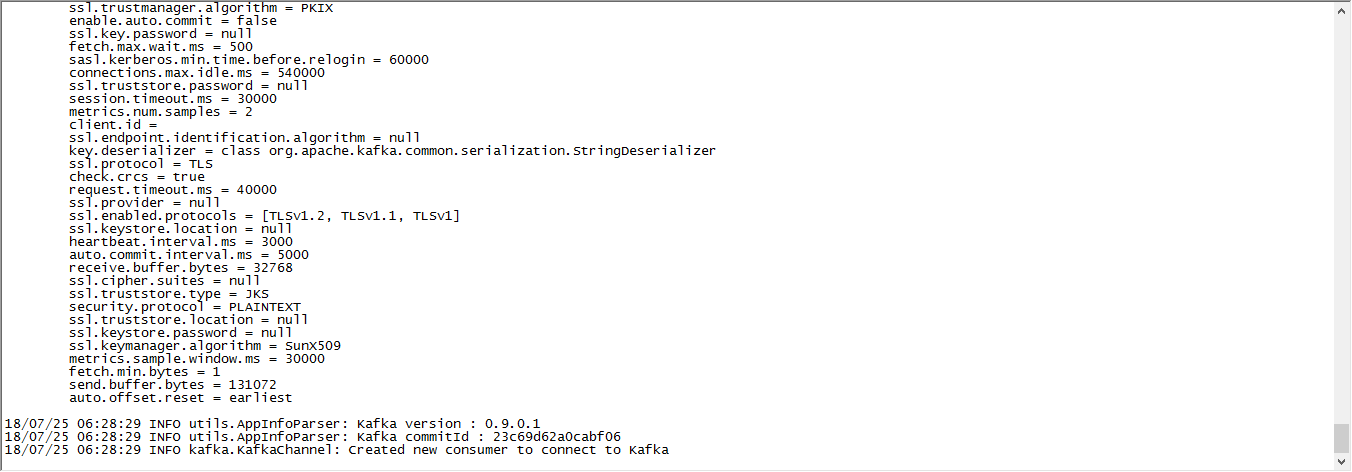

然后我启动后,如图所示:

这是怎么回事儿?求大哥大姐帮帮我呀,谢谢!

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享