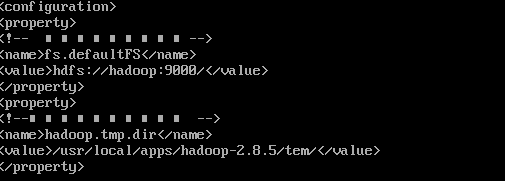

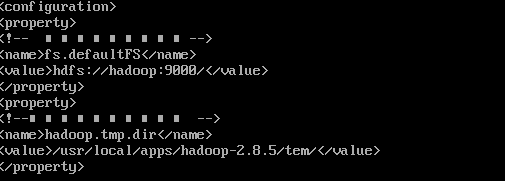

hadoop core-site.xml 配置如图

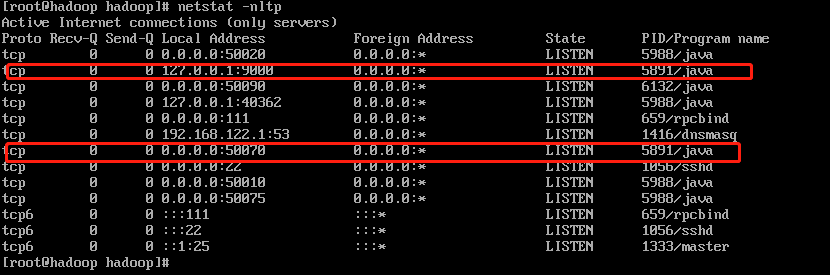

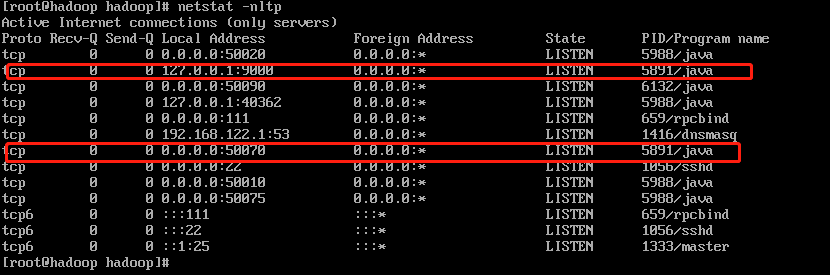

监听端口如图:

由于9000端口绑定到了127.0.0.1这个回环地址上,导致其他电脑不能访问hdfs文件系统。现在怎么做可以向50070端口一样,绑定到0.0.0.0地址上。

该问题的系统配置为:虚拟机虚拟的CentOS 7 系统,虚拟机之间可以ping通,22、 50070等绑定在0.0.0.0的端口可以正常telnet通,物理机也可以ping通虚拟机,telnet通22、50070等绑定在0.0.0.0地址的端口。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享