数据库小白一个,由于最近工作需要,要求把原来在csv里的数据拆分写入数据库中。所用的环境的mysql5.6以及Python3.6的pymysql。

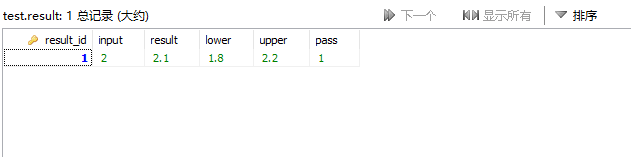

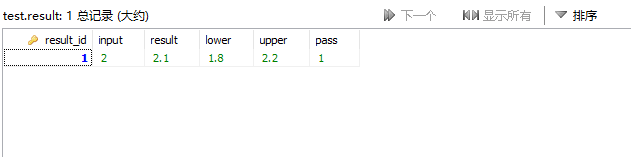

现在有两张表,result和context,result存放结果相关的数据,context存放设置相关的数据。现在需要从csv中读取一行,把其中有关结果相关数据写入result表中。这两个表通过result_id来对应。

一个csv里的数据有几千行,目前自己测试的方案是,往result写一条,由于result中的主键result_id是自增的,所以用select last_insert_id()获取得到result_id,然后往context写一条,这样速度很慢,2000条数据要1分多钟,有什么方法可以提高这个速度呢?

求大神指点迷津

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享