全联接神经网络是一种计算量比较大的机器学习模型,在训练和推断过程中需要对所有神经元进行矩阵计算。为了加快计算速度,各公司的大佬们采取了不同手段进行数据的抽象和综合。

通常来说,我们采用卷积操作,将数据进行抽象和综合,然后送入到全连接神经网络进行最后的计算,实质上就是矩阵运算等数学计算的一系列综合操作。

熟悉矩阵运算的朋友都知道,矩阵当中的每个元素和其他元素是没有关联的,这种特性天然就适合使用并行计算的方式来加快其计算速度。

重点来了!并行计算正是 FPGA 等芯片的强项,利用FPGA将有效实现深度学习神经网络的加速计算(推理),下面是具体的操作展示。

1. 深度学习神经网络的环境搭建

2. 安装 OpenCL的开发环境,使Intel Arria 10 FPGA作为OpenCL的设备,注意安Intel对应的SDK

3. 利用 Tensorflow 作为框架,实现一个简单的全连接神经网络

(提供一个算法描述示例,使用 Mnist 数据集作为训练和测试)

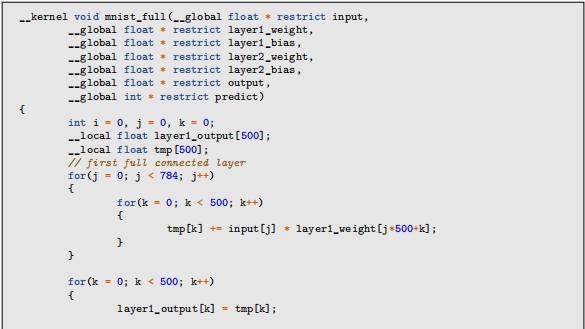

1)Mnist 数据集每张图片为 28×28 像素,将每张图片的像素点作为输入

2)第一个隐藏层设置 500 个神经元,与输入图像的 784 个像素点做计算(矩阵乘法)

3)将得到的结果使用 relu 函数进行结果,只保留数值 >0 的结果,其他的设置为 0

4)第二个隐藏层设置 10 个神经元,与第一个隐藏层的输出进行计算(矩阵乘法),最终得到 10 个结果作为输出

从上述的算法描述当中,我们可以看到实际上就是几次矩阵的计算过程:一个 [1,784] 和 [784, 500] 的矩阵乘法,得到一个 [1,500] 的中间矩阵;然后这个 [1,500] 的中间矩阵与 [500, 10] 的矩阵进行计算,最终得到一个 [1,10] 的矩阵,这个就是我们的最终结果。

4. 对搭建完成的神经网络进行训练,训练之后得到模型文件

5. 通过一定的操作方式,提取这些模型文件中的模型参数

6. 把模型参数当作输入的参数,送入到FPGA当中进行加速计算,实现推理过程

上述神经网络算法的OpenCL实现,大致如下:

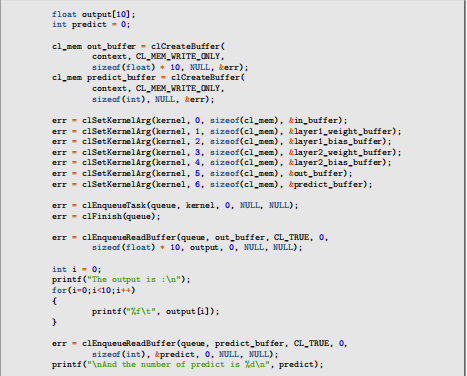

7. 最后使用C/C++编写CPU程序,与 FPGA 进行交互,来验证 OpenCL 算法实现的正确性。

以下是 CPU 程序的部分代码。

通过以上步骤,我们就成功的使用OpenCL在Intel FPGA上实现了一个简单的神经网络的推理加速。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享