222

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

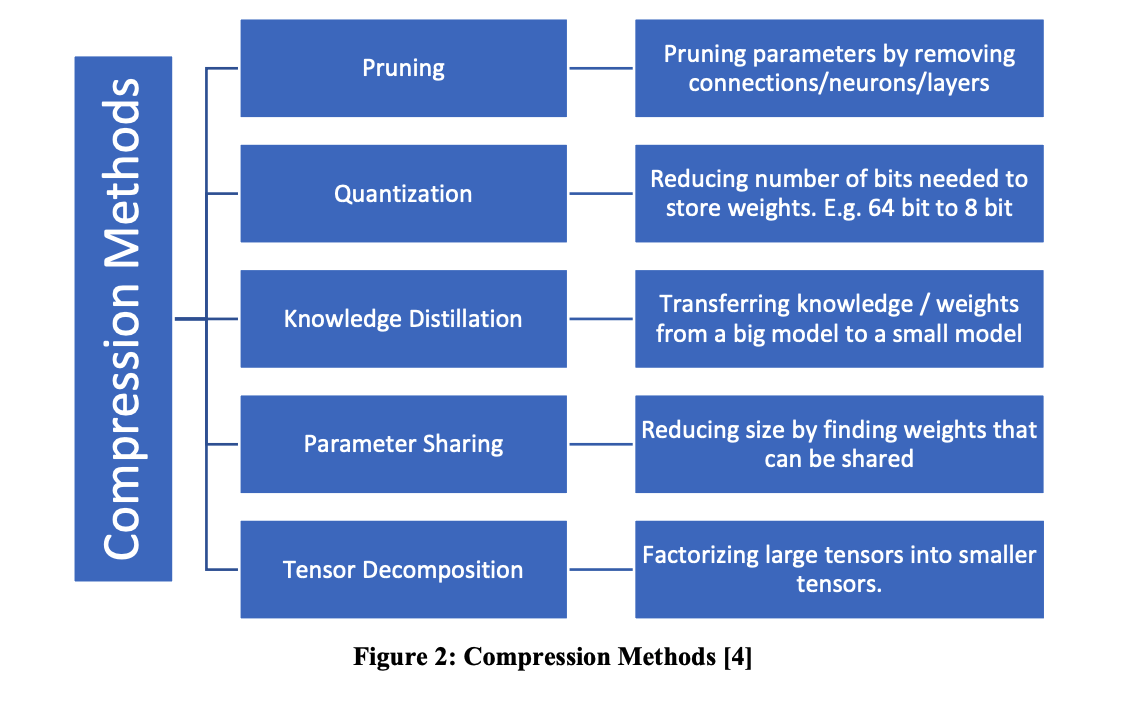

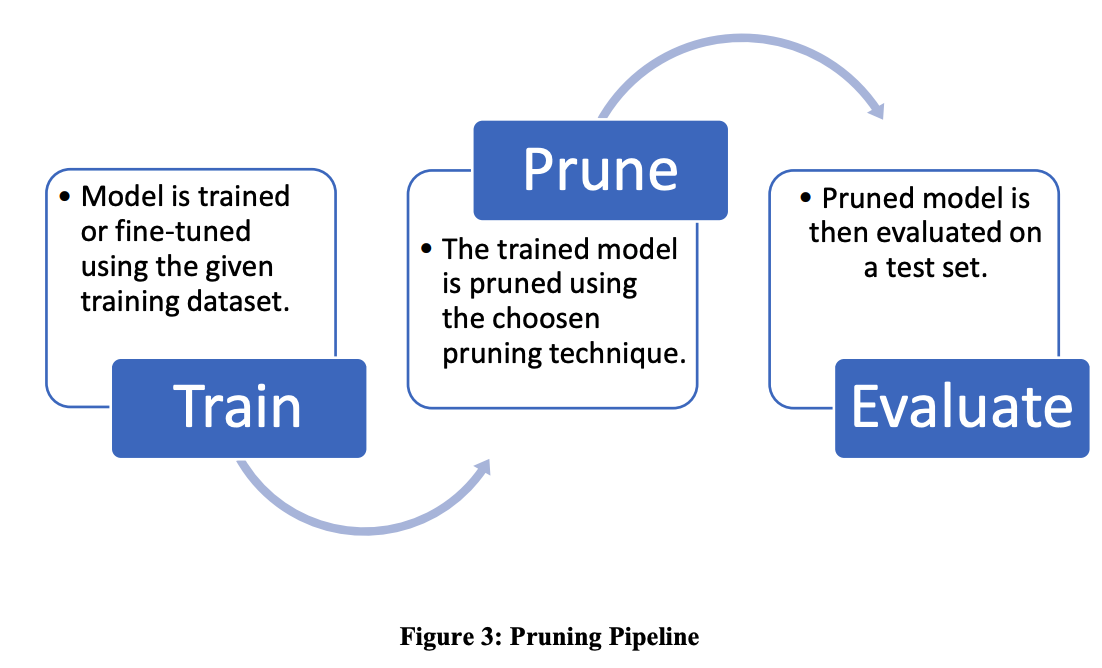

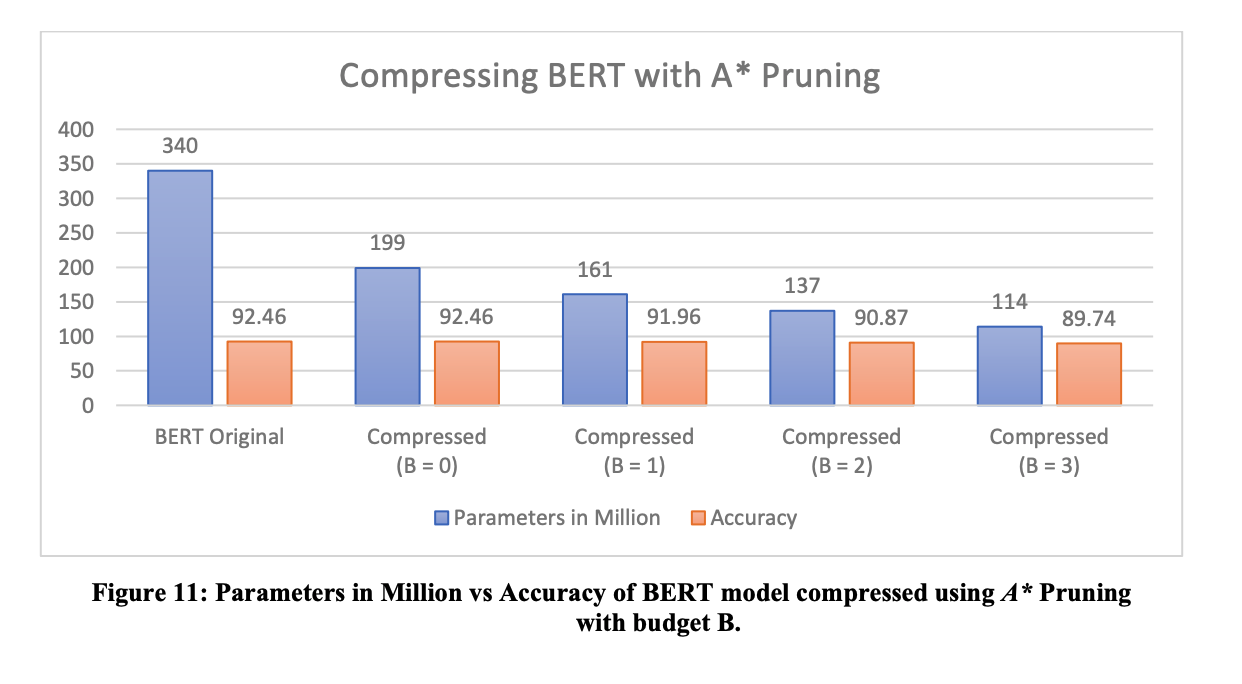

分享【使用A搜索修剪Transformer模型的Attention Heads:#一种压缩大型NLP架构的新方法#】近年来,在#自然语言处理# 甚至#计算机视觉# 中越来越多地采用#Transformer# 模型。然而,由于规模大小的原因,此类模型在资源受限的计算环境中采用率有限。本文提出了新颖的剪枝算法,通过消除冗余的Attention Heads来压缩Transformer模型。研究人员使用A搜索算法来获得具有最小精度保证的剪枝模型。结果表明,该方法可以消除#BERT# transformer模型中多达40%的Attention Heads,而几乎没有精度损失。论文: https://arxiv.org/pdf/2110.15225.pdf