535

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享模型发展: 专用模型->通用大模型(多任务, 多模态)

大语言模型

InternLM

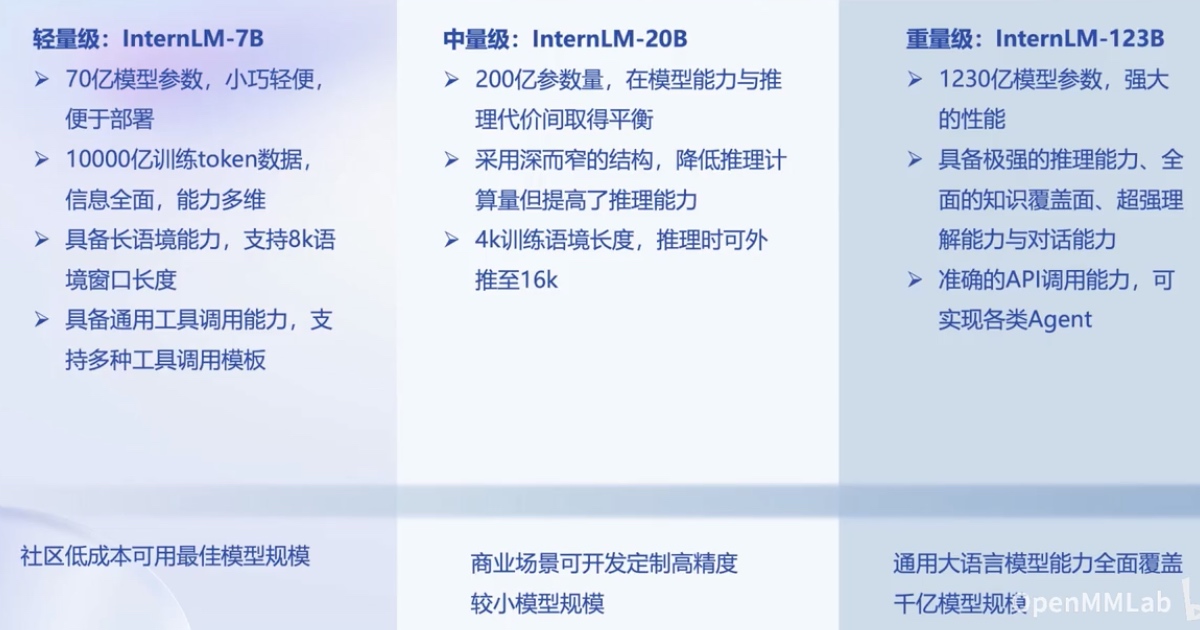

InternLM-7B模型 全链条开源工具体系

书生-万卷

InternLM-20B 大模型性能

能力: 综合考试 知识问答 阅读理解 推理 编程

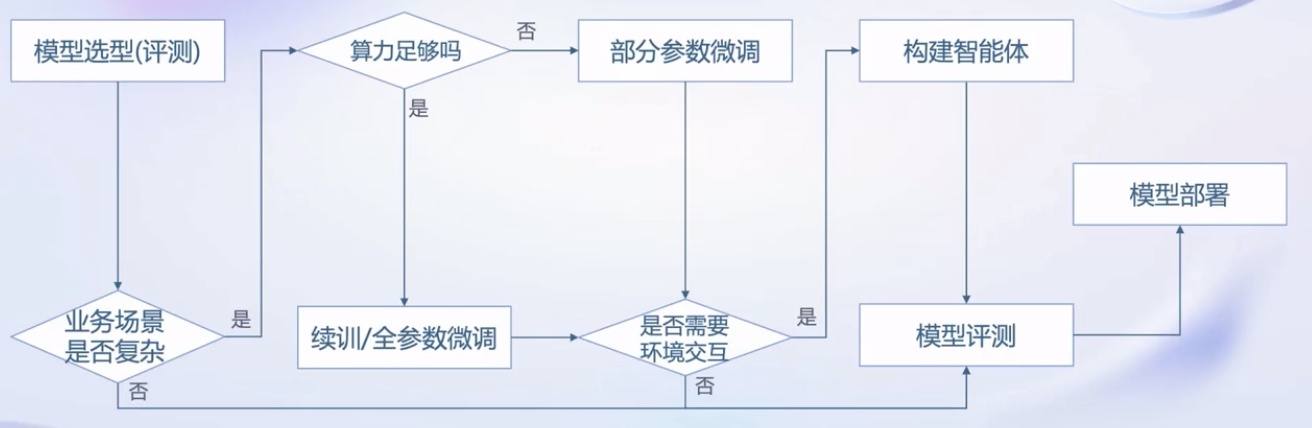

从模型到应用:

智能客服 个人助手 行业应用

书生-万卷

平台: OpenDataLab

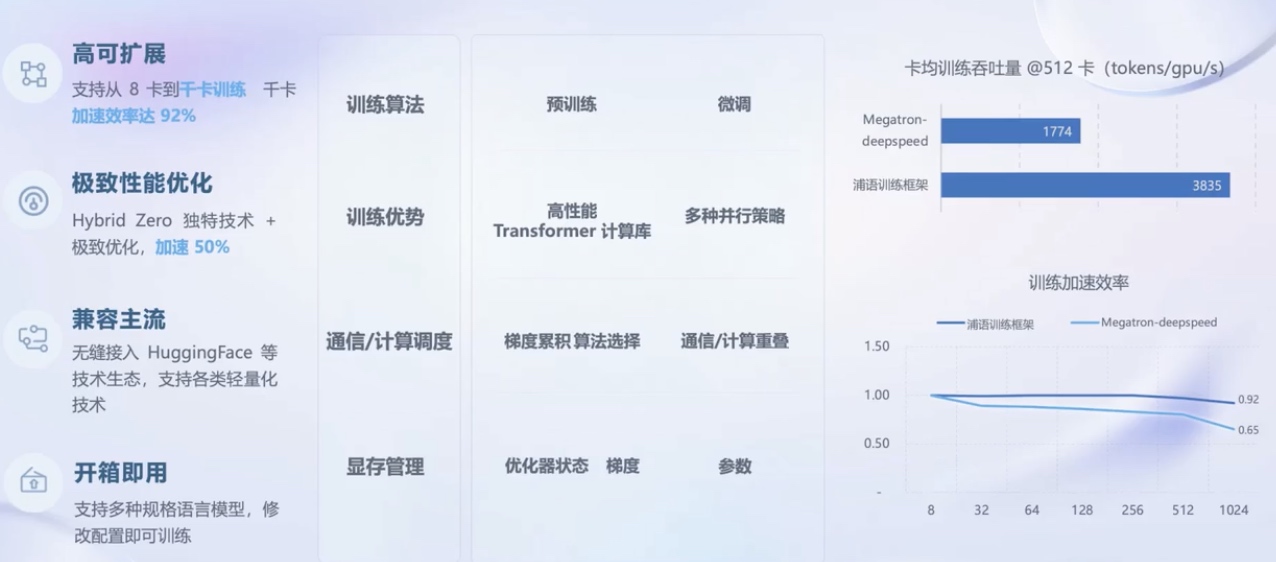

InternLM-train 并行训练

大语言模型的下游任务应用中, 增量续训和有监督微调是经常使用的两种方式

XTuner

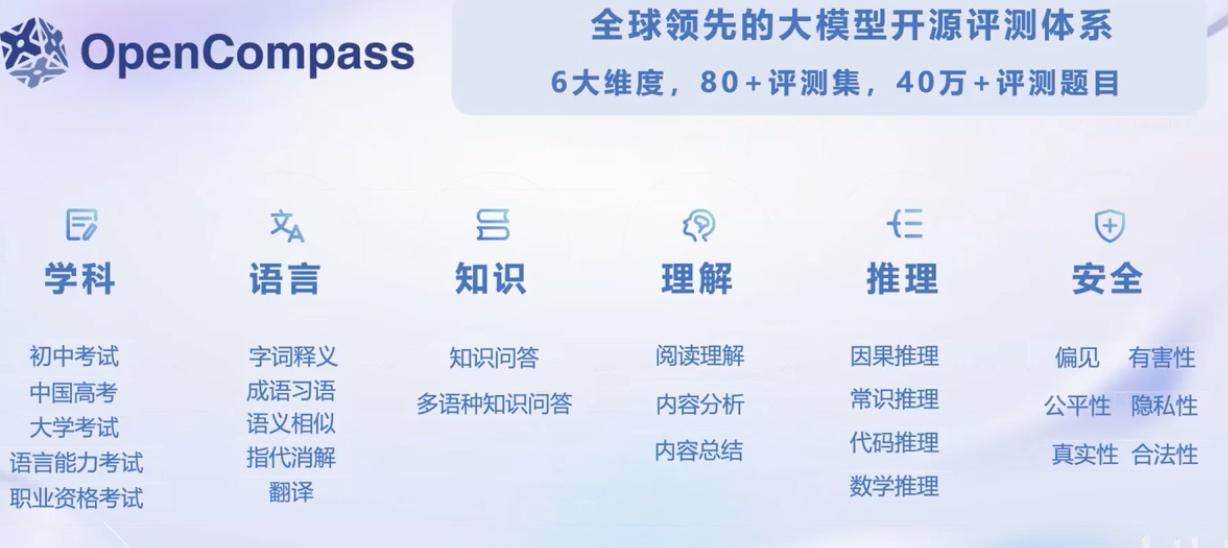

国内外评测体系的整体态势

OpenCompass

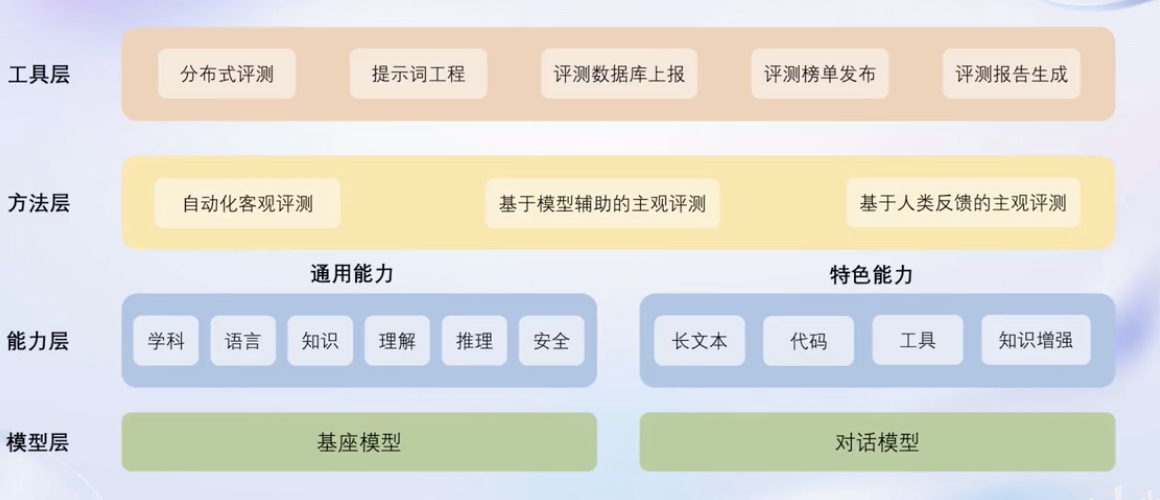

OpenCompass 开源评测平台架构

丰富模型支持

分布式高效评测

便携的数据集接口

敏捷的能力迭代

模型支持:

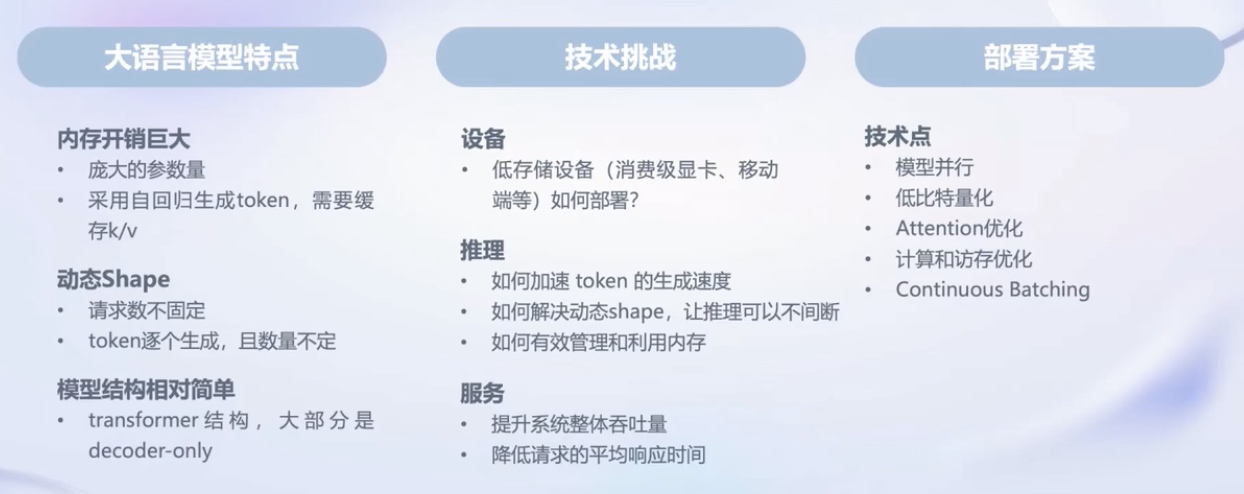

LMDeploy

提供大模型在GPU上部署的全流程解决方案包括模型轻量化, 推理和服务

静态推理性能(固定batch, 输入/输出token数量)

动态推理性能(真实对话, 不定长的输入/输出)

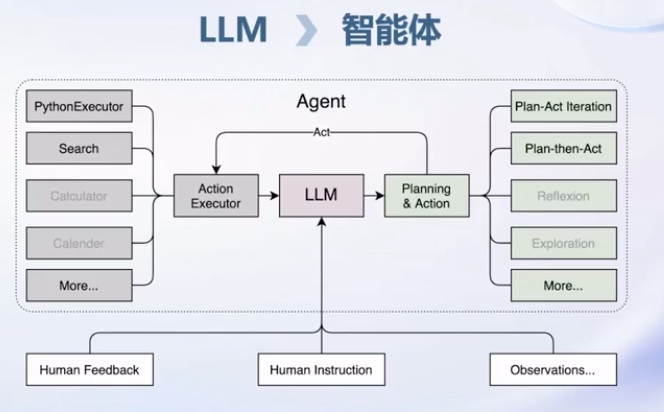

LLM局限性:

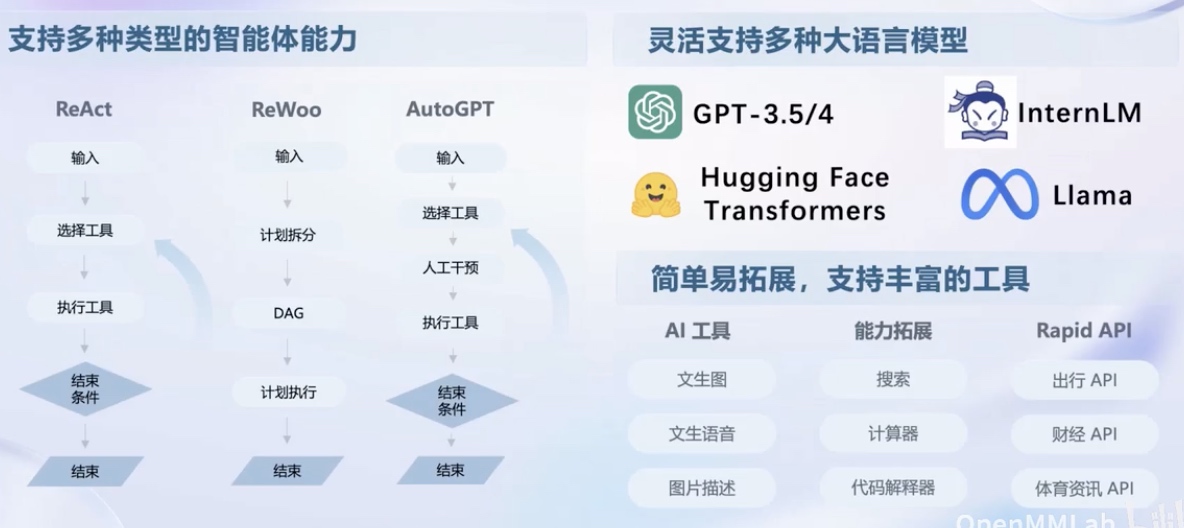

轻量级智能体框架 Lagent

代码解数学题

零样本泛化: 多模态AI工具使用

工具集合 AgentLego