小白写了一个队号码活跃度评分的模型,在IDEA上跑是没有问题的,跑100条号码大概几十秒。但是一放到集群上面,代码便一直运行半小时左右,最后就运行失败,查看日志显示就是内存溢出。请问有大神遇到过这个问题吗?求解决,已经困惑两天了,以前练习mlib的时,里面有两个方法也存在这种问题,本地能跑,集群上内存溢出。

网上查看说浭水spark-defaults.conf里面的spark.driver.extraJavaOptions -XX:PermSize=128M -XX:MaxPermSize=256M ,我改了可还是错。

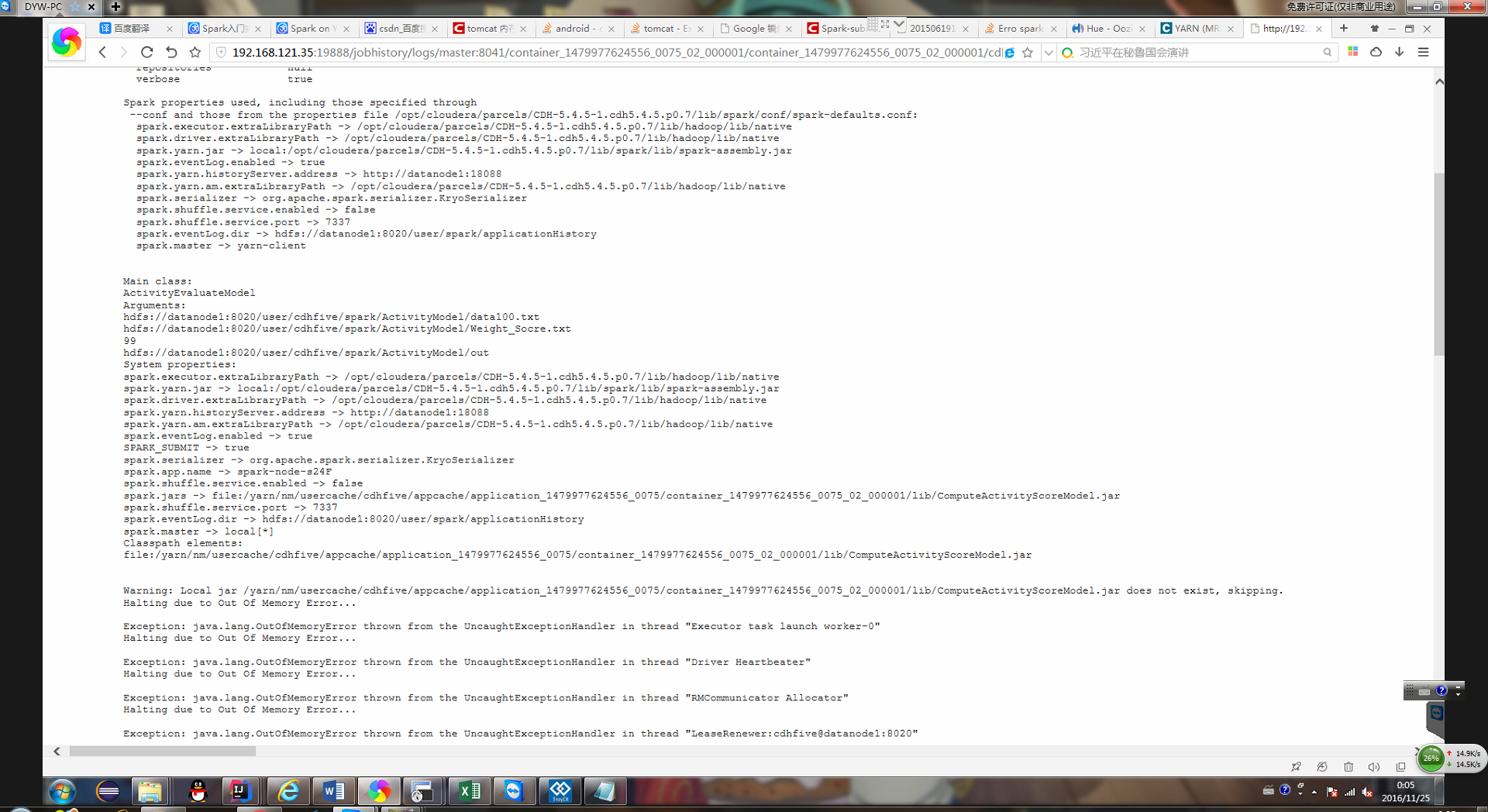

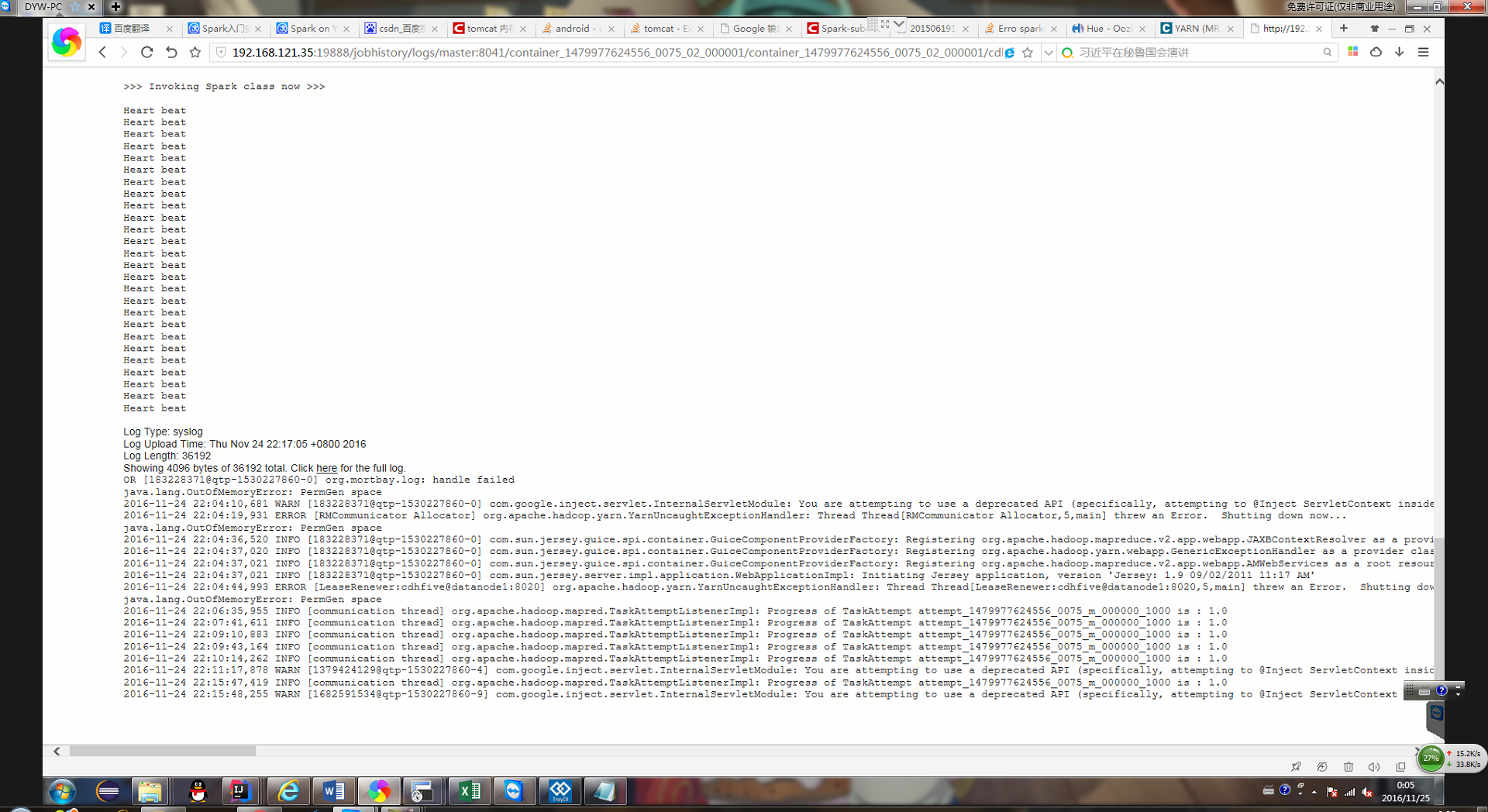

日志内容如下:

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享