《Spark核心黑科技:花了一天时间深度解剖RDD分区策略与数据倾斜》(全网最强)

社区首页 (3653)

请编写您的帖子内容

社区频道(4)

显示侧栏

卡片版式

全部

博文收录

Ada助手

问答

最新发布

最新回复

标题

阅读量

内容评分

精选

143

评分

回复

《Spark核心黑科技:花了一天时间深度解剖RDD分区策略与数据倾斜》(全网最强)

摘要 《RDD深度解析:从数学证明到源码级理解》 受众🔥:大数据面试备战者 | Spark性能优化工程师 | 分布式系统研究者 核心价值: 🧪 实验层:内存/磁盘操作实测对比 📜 理论层:分区数据分布数学证明和源码解析

复制链接 扫一扫

分享

122

评分

回复

spark 分析报错,有大佬遇到吗

<parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>3.4.1</ver

复制链接 扫一扫

分享

418

评分

3

eclipse 本地local运行Spark程序报错

import org.apache.spark.SparkConf import org.apache.spark.SparkContext import org.apache.spark.rdd.RDD object HelloWorld {

复制链接 扫一扫

分享

316

评分

回复

spark.driver.extraJavaOptions=-Dlog4j.configuration=log4j.properties

spark-submit \ –class com.example.YourMainClass \ –master yarn \ –deploy-mode cluster \ –files /path/to/log4j.properties#log4

复制链接 扫一扫

分享

1828

评分

回复

spark Flume问题

ERROR Executor:91 - Exception in task 0.0 in stage 1124.0 (TID 1090) java.lang.AbstractMethodError: org.apache.spark.streamin

复制链接 扫一扫

分享

494

评分

3

scala安装后命令行启动出现java异常

1. 在windows环境下,安装Java运行环境和SDK 2. 安装scala 3. 在cmd命令行直接输入scala启动scala环境,出现以下异常 Exception in thread "main" java.nio.file.Invalid

复制链接 扫一扫

分享

441

评分

2

在python中应用pyspark出现这个提示,这个怎么修改啊?

[图片]

复制链接 扫一扫

分享

请问如何在社区发文章?

...全文

697

评分

1

扫一扫

分享

652

评分

1

“1024 程序员节|用代码,改变世界” 主题征文开启,限定勋章&丰富周边大奖等你拿!快来投稿吧~

“1024 程序员节|用代码,改变世界” 主题征文开启,限定勋章&丰富周边大奖等你拿!快来投稿吧~ 社区云2022-10-20 18:03:30 hello, 大家好! 我已申请成为今年“1024 程序员节|用代码,改变世界” 主题征文活动的领航员

复制链接 扫一扫

分享

407

评分

回复

【GraphX】有无全局节点属性聚合函数

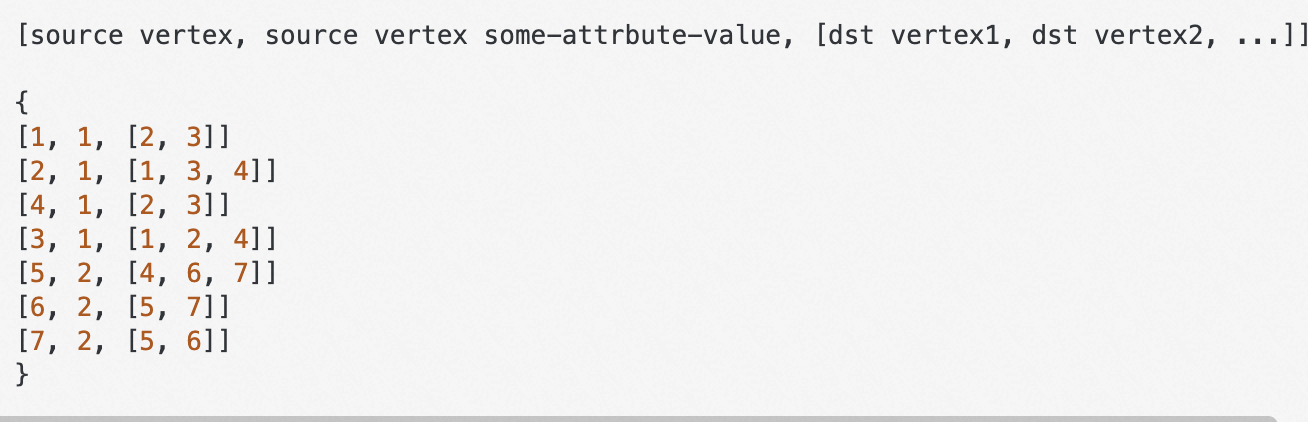

统计图中节点不同属性值相应的数目,类似于python中collections.Counter 假设有一个图 则希望输出: {1: 4, 2: 3} 或者输出具体的节点: {1: [1, 2, 3, 4], 2: [5, 6, 7]} 我希望最终这个函

复制链接 扫一扫

分享

500

3.0

回复

6.编写Spark独立应用程序(sbt)(华为云学习笔记,Spark编程基础,大数据)

编写Spark独立应用程序(sbt)① 使用Scala语言编写Spark独立应用程序;② 使用sbt工具对Spark应用程序进行编译打包。实验原理-> sbtSBT是一个现代化的构建工具。虽然它由Scala编写并提供了很多Scala便利,但它是一个通用的构建工具。可以使用sbt工具,对采用Scala语言编写的Spark应用程序进行编译打包。1. 安装sbt工具下载安装包请打开浏览器访问如下链接进行下载拷贝代码http://file.ictedu.com/fileserver/big_data_

复制链接 扫一扫

分享

448

评分

回复

7.读写HBase数据(华为云学习笔记,Spark编程基础,大数据)

读写HBase数据① 在hbase-shell中使用命令创建HBase数据库;② 使用Spark读写HBase数据库中的数据。实验原理-> HBaseHBase是一个高可靠、高性能、面向列、可伸缩的分布式数据库,主要用来存储非结构化和半结构化的松散数据。HBase的目标是处理非常庞大的表,可以通过水平扩展的方式,利用廉价计算机集群处理由超过10亿行数据和数百万列元素组成的数据表。-> hbase-shellhbase-shell是一种HBase交互式操作环境,可以在其中输入命令,完成数据库创建和

复制链接 扫一扫

分享

432

2.0

回复

3.Scala的安装和使用方法(华为云笔记,大数据)

Scala的安装和使用方法① 在Linux系统中安装Scala;② 使用Scala REPL;③ 编译打包Scala程序代码。实验原理-> ScalaScala于2004年1月公开发布1.0版本,目前仍处于快速发展阶段,每隔几个月就有新的版本发布。Spark从2.0版本开始都采用Scala2.11编译,因为本教程使用的Spark版本是2.1.0,其对应的Scala版本是2.11.8,所以,本教程中的Scala选用2017年4月发布的2.11.8版本。Scala运行在Java虚拟机(JVM)之上,

复制链接 扫一扫

分享

684

5.0

回复

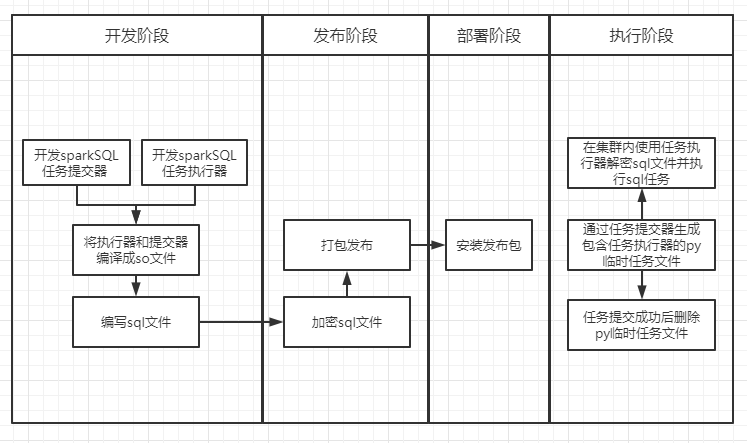

保护基于sparkSQL的sql模型

1、背景 我们在做项目或者研发产品时,部署的程序一般都是二进制文件,甚至还会进行一些混淆(如果jar文件、前端的js文件等),这样可以尽量避免第三方未授权就对我们的程序进行分析,对我们的程序也是一种保护。但是在大数据时代,我们的分析模型大部分都是以

复制链接 扫一扫

分享

439

评分

回复

【scala函数式编程】严格求值和惰性求值

介绍scala惰性求值,通过创建一个Stream,对比直接求值和惰性求值的差异,更进一步的,介绍了无限流与共递归

复制链接 扫一扫

分享

431

评分

回复

【scala函数式编程】函数式数据结构

定义一个函数式数据结构,并基于该数据结构,将递归操作泛化为高阶函数

复制链接 扫一扫

分享

441

评分

回复

【scala函数式编程】函数式编程中的异常处理

对scala异常处理进行简明的介绍,准确描述Option、Either的两个主要功能:值的封装、函数的提升

复制链接 扫一扫

分享

449

5.0

回复

手把手带你玩转Spark机器学习-使用Spark构建回归模型

系列文章目录手把手带你玩转Spark机器学习-专栏介绍手把手带你玩转Spark机器学习-问题汇总[持续更新]手把手带你玩转Spark机器学习-Spark的安装及使用手把手带你玩转Spark机器学习-使用Spark进行数据处理和数据转换手把手带你玩转Spark机器学习-使用Spark构建分类模型文章目录系列文章目录前言一、pandas是什么?二、使用步骤1.引入库2.读入数据总结前言提示:这里可以添加本文要记录的大概内容:例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很

复制链接 扫一扫

分享

447

评分

回复

Hadoop的安装和使用---华为云学习笔记(校企桥)大数据学习----大数据技术原理与应用实验-----Hadoop的安装和使用

此笔记为第一篇,学校开放华为云平台,帮助我们学习有关大数据方面相关知识的学习笔记,因为是云平台,是已经搭建好linux环境了,使用的是Ubantu。精心整理,自学笔记,如有什么问题,请耐心指正Hadoop的安装和使用学习Hadoop的安装和使用1 安装Hadoop前的准备工作介绍安装Hadoop之前的一些准备工作,包括创建hadoop用户、安装SSH和安装Java环境等。先配置hosts,输入以下命令,将本机的hostname添加到hosts文件中:拷贝代码echo "127.0.0.1 "$H

复制链接 扫一扫

分享

为您搜索到以下结果:

1,275

社区成员

1,171

社区内容

发帖

发帖 与我相关

与我相关 我的任务

我的任务

Spark

Spark由Scala写成,是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于MapReduce算法实现的分布式计算。

复制链接 扫一扫

分享

分享确定

社区描述

Spark由Scala写成,是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于MapReduce算法实现的分布式计算。

加入社区

获取链接或二维码

- 近7日

- 近30日

- 至今

加载中

社区公告

暂无公告