关于MASTER=spark://SparkMaster:7077 ./spark-shell问题

小白鸽 2014-11-26 02:38:56

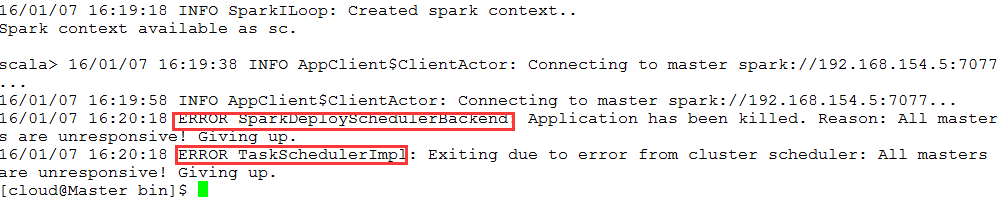

小白鸽 2014-11-26 02:38:56 在运行MASTER=spark://SparkMaster:7077 ./spark-shell时候

出现scala了,但是后面紧接着出现了。

14/11/25 06:02:08 WARN client.AppClient$ClientActor: Could not connect to akka.tcp://sparkMaster@SparkMaster:7070: akka.remote.EndpointAssociationException: Association failed with [akka.tcp://sparkMaster@SparkMaster:7070]

14/11/25 06:02:08 WARN client.AppClient$ClientActor: Could not connect to akka.tcp://sparkMaster@SparkMaster:7070: akka.remote.EndpointAssociationException: Association failed with [akka.tcp://sparkMaster@SparkMaster:7070]

14/11/25 06:02:28 ERROR cluster.SparkDeploySchedulerBackend: Application has been killed. Reason: All masters are unresponsive! Giving up.

14/11/25 06:02:28 ERROR scheduler.TaskSchedulerImpl: Exiting due to error from cluster scheduler: All masters are unresponsive! Giving up.

在错误日志中发现

14/11/25 21:51:40 ERROR remote.EndpointWriter: AssociationError [akka.tcp://sparkMaster@SparkMaster:7077] -> [akka.tcp://spark@SparkMaster:34726]: Error [Association failed with [akka.tcp://spark@SparkMaster:34726]] [

akka.remote.EndpointAssociationException: Association failed with [akka.tcp://spark@SparkMaster:34726]

Caused by: akka.remote.transport.netty.NettyTransport$$anonfun$associate$1$$anon$2: Connection refused: SparkMaster/192.168.64.129:34726

]这条语句

也不知道到底怎么弄。

然后我对比和别人的运行,我的是akka.tcp://sparkMaster@SparkMaster:7070:

而别人是akka.tcp://spark@SparkMaster:7070:配置都一样,是不是这个原因。

比较有意思的是,如果直接在bin文件夹下启动spark shell,倒能运行成功。

然后我把MASTER=spark://SparkMaster:7077 ./spark-shell中的SparkMaster直接改成主节点Ip,倒不出现14/11/25 06:02:08 WARN client.AppClient$ClientActor: Could not connect to akka.tcp://sparkMaster@SparkMaster:7070: akka.remote.EndpointAssociationException: Association failed with [akka.tcp://sparkMaster@SparkMaster:7070]这句话了,还是出现14/11/25 06:02:28 ERROR scheduler.TaskSchedulerImpl: Exiting due to error from cluster scheduler: All masters are unresponsive! Giving up.错误。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享