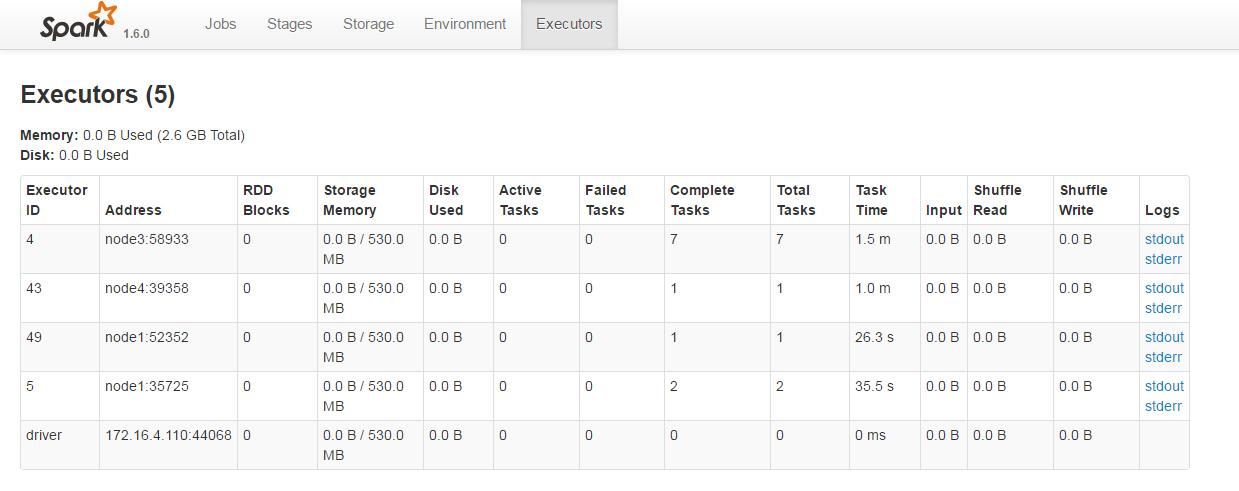

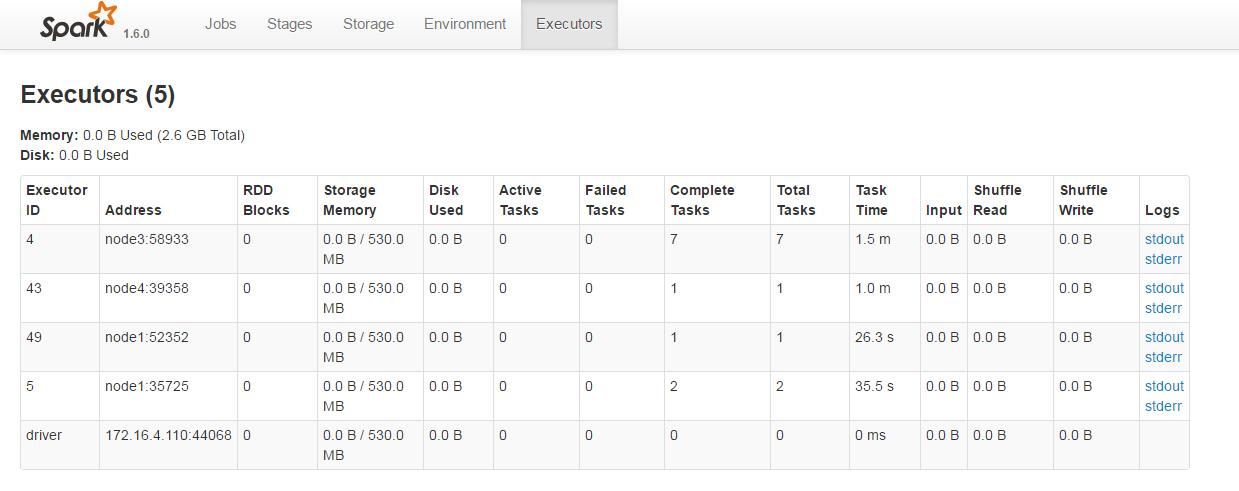

master以yarn的方式跑,通过http://node1:18088/history/application_1470281024284_0054/executors/,可以看到如下图所示信息,

应用程序即driver的日志无法查看,我试过将logger.info改成logger.warn也看不到。

故请问:

1.driver的日志如何查看?

2.我的程序如何指定自己的log4j.properties,不要告诉我放到${SPARK_HOME}/conf/下,因为那会对所有spark应用都生效,我只想对自己这个应用生效;我试过把log4j.properties放到项目的resources下,但不管用。

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享