1,261

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享object AccumulatorTest extends App{

val appName = "AccumulatorTest"

val master = "local"

//自己写的简单工具类获得sc

val sc = SparkUtil.getSparkContext(appName, master)

val list = List(1, 2, 3, 4, 5)

val listRDD = sc.parallelize(list)

val accumulator = sc.accumulator(0, "MAP_ACCUMULATOR")

val mapRDD = listRDD.map(num => {

accumulator.add(1)

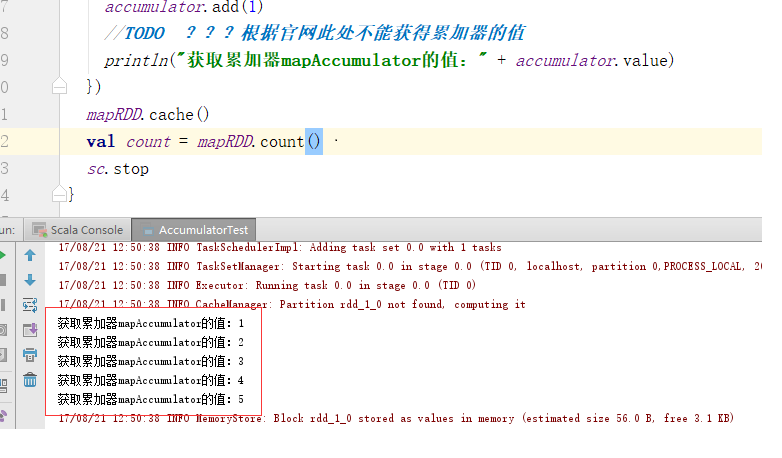

//TODO ???根据官网此处不能获得累加器的值

println("获取累加器mapAccumulator的值:" + accumulator.value)

})

mapRDD.cache()

val count = mapRDD.count()

sc.stop

}