7,084

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

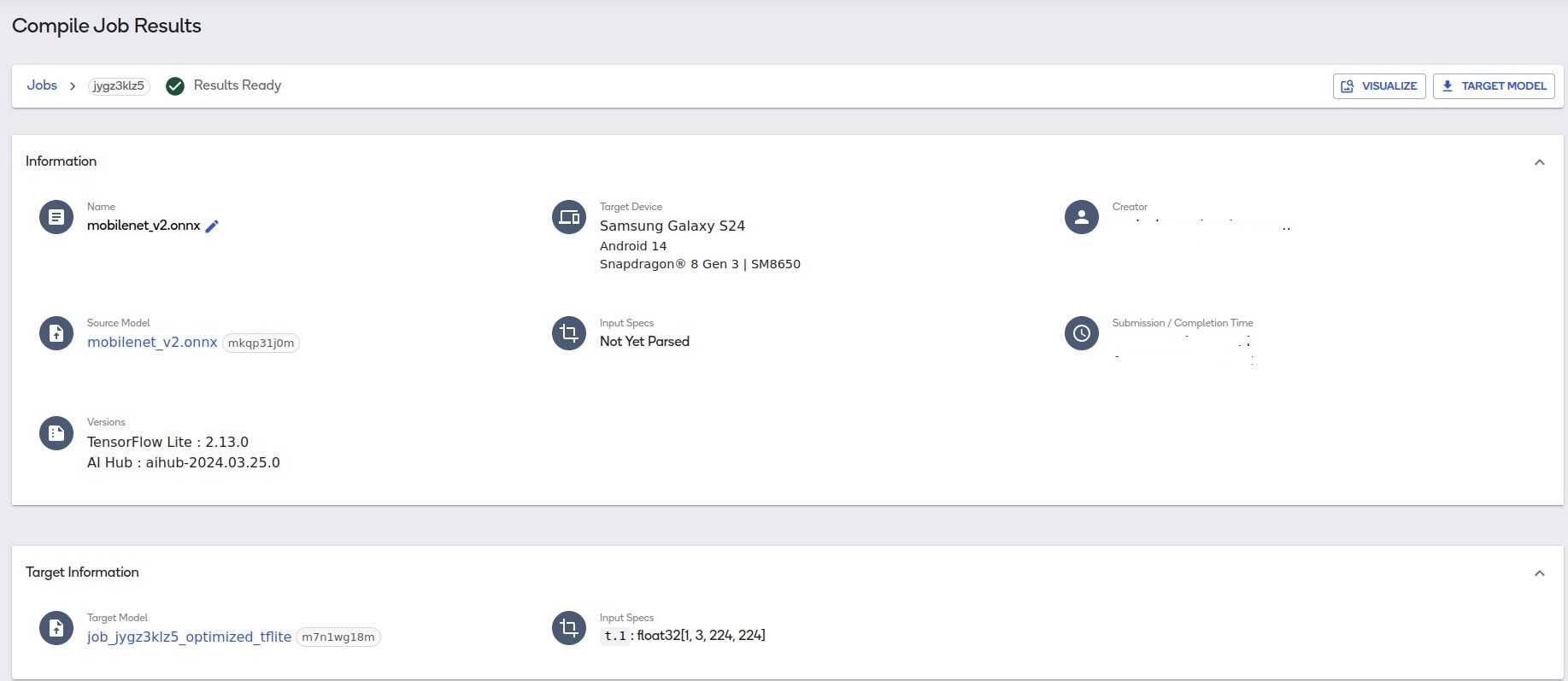

分享Qualcomm® AI Hub支持Pytorch、ONNX、AIMET、Tensorflow等主流AI框架训练的模型,本文介绍了如何使用AI Hub相关的SDK接口把这些模型编译成TensorFlow Lite和Qualcomm AI Engine Direct (QNN)。具体的基于python的编程实现参考中文文档:Qualcomm AI Hub-示例(一)编译模型-CSDN博客

除了可以用python编程实现模型的编译,我们也可以使用命令行来做模型的编译

1.命令行将onnx模型编译成tflite模型,使用的mobilenet_v2.onnx 模型下载链接:

https://qaihub-public-assets.s3.us-west-2.amazonaws.com/apidoc/mobilenet_v2.onnx

命令行: qai-hub submit-compile-job --model ./mobilenet_v2.onnx --device "Samsung Galaxy S24"

编译结果如下:

2.命令行将onnx模型编译成QNN android下使用的模型,使用的mobilenet_v2.onnx 模型同上。

命令行: qai-hub submit-compile-job --model ./mobilenet_v2.onnx --device "Samsung Galaxy S24" --compile_options "--target_runtime qnn_lib_aarch64_android"

编译结果如下:

同时你还可以讲pytorch模型编译成tflite或者QNN格式,mobilenet_v2.pt模型下载:https://qaihub-public-assets.s3.us-west-2.amazonaws.com/apidoc/mobilenet_v2.pt

可参考以下命令

qai-hub submit-compile-job --model ./mobilenet_v2.pt --input_specs "{'image': (1, 3, 224, 224)}" --device "Samsung Galaxy S23"

qai-hub submit-compile-job --model ./mobilenet_v2.pt --input_specs "{'image': (1, 3, 224, 224)}" --device "Samsung Galaxy S23" --compile_options "--target_runtime qnn_lib_aarch64_android"

这样,不用一行代码就可以实现模型的编译。