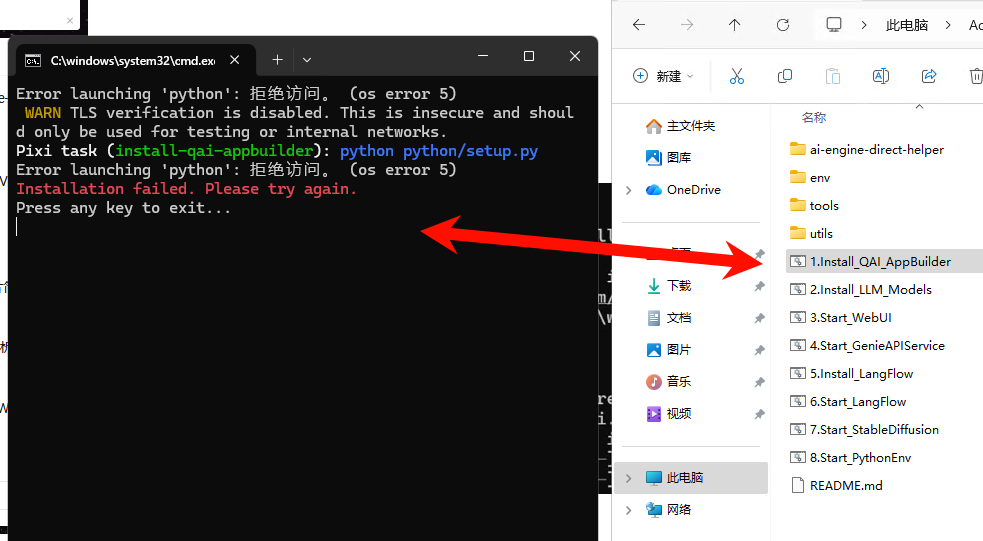

QAI的批处理文件无法运行

社区首页 (3658)

请编写您的帖子内容

社区频道(17)

显示侧栏

卡片版式

全部

AI 人工智能

生成式 AI

AI Edge Box

AI PC

IoT 物联网

XR/VR/AR/MR

Gaming 游戏

Auto 汽车

AI 大赛

博文收录

开发者中文专区

博客

活动

资讯

视频

硬件开发案例

最新发布

最新回复

标题

阅读量

内容评分

精选

40

评分

3

QAI的批处理文件无法运行

按照教程,在QAI_AppBuilder的部署中运行远程主机已有的批处理文件,报错信息如上,麻烦工作人员解答并给出解决方案,谢谢!

复制链接 扫一扫

分享

AI 大赛

36

评分

1

在QCS9075上部署Stable diffusion 2.1时遇到如下问题

在QCS9075上部署Stable diffusion 2.1时遇到如下问题 [LE和LU均]无法从Hugingface获取某些内容,例如: '(MaxRetryError("HTTPSConnectionPool(host='huggingface

复制链接 扫一扫

分享

IoT 物联网

38

评分

1

6490平台上部署动作识别模型遇到如下问题

6490平台上部署动作识别模型遇到如下问题 在RB3 Gen2 Ubuntu 20.04上直接登录Edge Impulse平台时,会出现错误: 初始化Linux工具失败 错误:未找到任何网络摄像头 在 initCamera (/usr/lib/nod

复制链接 扫一扫

分享

IoT 物联网

30

评分

2

Snapdragon 游戏手机上的 Adreno GPU 驱动调试工具有哪些?如何查看 GPU 占用和渲染瓶颈?

Snapdragon 游戏手机上的 Adreno GPU 驱动调试工具有哪些?如何查看 GPU 占用和渲染瓶颈?

复制链接 扫一扫

分享

Gaming 游戏

29

评分

1

使用 SNPE 在手机端做实时目标检测时,NPU 延迟不稳定(有时突然变高),可能原因有哪些?

使用 SNPE 在手机端做实时目标检测时,NPU 延迟不稳定(有时突然变高),可能原因有哪些?

复制链接 扫一扫

分享

AI 人工智能

24

评分

1

在 Windows on Snapdragon (WoA) 上做本地 AI 推理,C++ 工程里如何正确链接 Qualcomm AI 相关库?

在 Windows on Snapdragon (WoA) 上做本地 AI 推理,C++ 工程里如何正确链接 Qualcomm AI 相关库?

复制链接 扫一扫

分享

AI PC

29

评分

1

Qualcomm Game Super Resolution (GSR) 在 Unity 里怎么接入?需要改渲染管线吗?

Qualcomm Game Super Resolution (GSR) 在 Unity 里怎么接入?需要改渲染管线吗?

复制链接 扫一扫

分享

Gaming 游戏

27

评分

1

在 Snapdragon 上做 Adreno GPU 推理时,和 Hexagon NPU 相比,一般哪些算子或模型更适合用 GPU?

在 Snapdragon 上做 Adreno GPU 推理时,和 Hexagon NPU 相比,一般哪些算子或模型更适合用 GPU?

复制链接 扫一扫

分享

AI 人工智能

28

评分

1

Snapdragon Elite X 上做 LLM 推理时显存或内存不足怎么办?有无推荐的模型大小和批处理策略?

Snapdragon Elite X 上做 LLM 推理时显存或内存不足怎么办?有无推荐的模型大小和批处理策略?

复制链接 扫一扫

分享

AI PC

26

评分

1

在 Qualcomm Neural Processing SDK 里,如何把 ONNX 模型量化成 INT8,具体要调哪些接口?

在 Qualcomm Neural Processing SDK 里,如何把 ONNX 模型量化成 INT8,具体要调哪些接口?

复制链接 扫一扫

分享

AI 人工智能

26

评分

1

高通终端AI软件栈在模型部署流程中,主要提供哪些自动化优化与工具链能力?

高通终端AI软件栈在模型部署流程中,主要提供哪些自动化优化与工具链能力?

复制链接 扫一扫

分享

AI 人工智能

38

评分

1

genie推理投机采样llama2_ssd的疑问

根据tutorial_for_llama2_ssd_auto教程,我生成了QNN context binaries和kv-cache.primary.qnn-htp等模型文件,下一步应该如何在高通8550芯片上执行推理呢? tutorials的qnn

复制链接 扫一扫

分享

AI 人工智能

98

评分

6

BGE-Base-Zh-V1.5 运行失败

BGE-Base-Zh-V1.5 运行失败

复制链接 扫一扫

分享

AI 大赛

高通新的网站如何查询当前基线是否包含某个CR?

高通CR

...全文

55

评分

3

高通新的网站如何查询当前基线是否包含某个CR?

高通CR

复制链接 扫一扫

分享

IoT 物联网

51

评分

1

如何部署多模态模型Qwen3-VL-2B-Instruct到高通车载芯片?

部署工具链 模型格式 是否需要量化 ……

复制链接 扫一扫

分享

Auto 汽车

117

评分

3

关于onnx使用GPU作为backend

官网教程与ort_setup.ps1脚本都让人有点混乱: 首先是官网的: 为什么GPU的backend使用了QNNExecutionProvider呢? 其次: 按照setup脚本为什么GPU EP使用和CPU EP一样的环境,这样我安装了onnxr

复制链接 扫一扫

分享

AI 大赛

83

评分

7

melotts_en 这个模型要如何使用?

https://aihub.qualcomm.com/models/melotts_en 请问这个模型要如何使用?

复制链接 扫一扫

分享

AI 大赛

51

评分

1

高通边缘AI技术在工业物联网场景中,如何实现AI模型的远程更新与持续迭代部署?

高通边缘AI技术在工业物联网场景中,如何实现AI模型的远程更新与持续迭代部署?

复制链接 扫一扫

分享

IoT 物联网

42

评分

1

在多模态AI任务处理中,高通硬件平台如何实现视觉、语音等模态数据的高效协同处理?

在多模态AI任务处理中,高通硬件平台如何实现视觉、语音等模态数据的高效协同处理?

复制链接 扫一扫

分享

AI 人工智能

44

评分

1

高通终端AI软件栈在模型部署流程中,主要提供哪些自动化优化与工具链能力?

高通终端AI软件栈在模型部署流程中,主要提供哪些自动化优化与工具链能力?

复制链接 扫一扫

分享

AI 人工智能

为您搜索到以下结果:

7,150

社区成员

6,171

社区内容

发帖

发帖 与我相关

与我相关 我的任务

我的任务

高通开发者论坛

本论坛以AI、WoS 、XR、IoT、Auto、生成式AI等核心板块组成,为开发者提供便捷及高效的学习和交流平台。

高通开发者专区主页:https://qualcomm.csdn.net/

复制链接 扫一扫

分享

分享确定

社区描述

本论坛以AI、WoS 、XR、IoT、Auto、生成式AI等核心板块组成,为开发者提供便捷及高效的学习和交流平台。

高通开发者专区主页:https://qualcomm.csdn.net/ 人工智能物联网机器学习 技术论坛(原bbs) 北京·东城区

加入社区

获取链接或二维码

- 近7日

- 近30日

- 至今

加载中

社区公告

暂无公告