5,341

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享SNPE 量化模型在安卓设备dsp上运行失败了:

SNPE版本:2.16

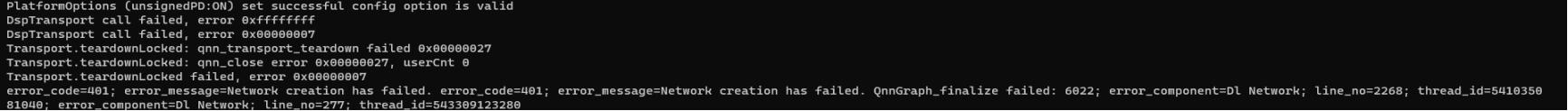

量化模型在安卓上运行时有如下报错:

详细说明:该模型为多输入模型,指定设备为--use_dsp时失败,指定设备为--use_gpu上时可成功运行,如何定位解决该模型在dsp上运行失败的问题

onnx转dlc:

snpe-onnx-to-dlc -i model.onnx -o model.dlc

量化命令:

snpe-dlc-quantize --input_dlc=model.dlc --input_list=/quantized_data/raw_list.txt --output_dlc=model.int8.dlc

注意:

raw_list.txt和需要的bin文件已经在上面的压缩包中一起发你了(raw_list.txt中的图像顺序不能修改),模型路径根据具体情况更改.

注意: DSP是进行了量化, 所以需要确认每一层的数据范围, 如果你的数据范围超过了INT8, 就会有精度的损失, 如果超过了int32 在运行的时候就会报出来的错误, 需要在训练的时候, 请增加一些BN层,以抑制数据的范围。