4,654

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

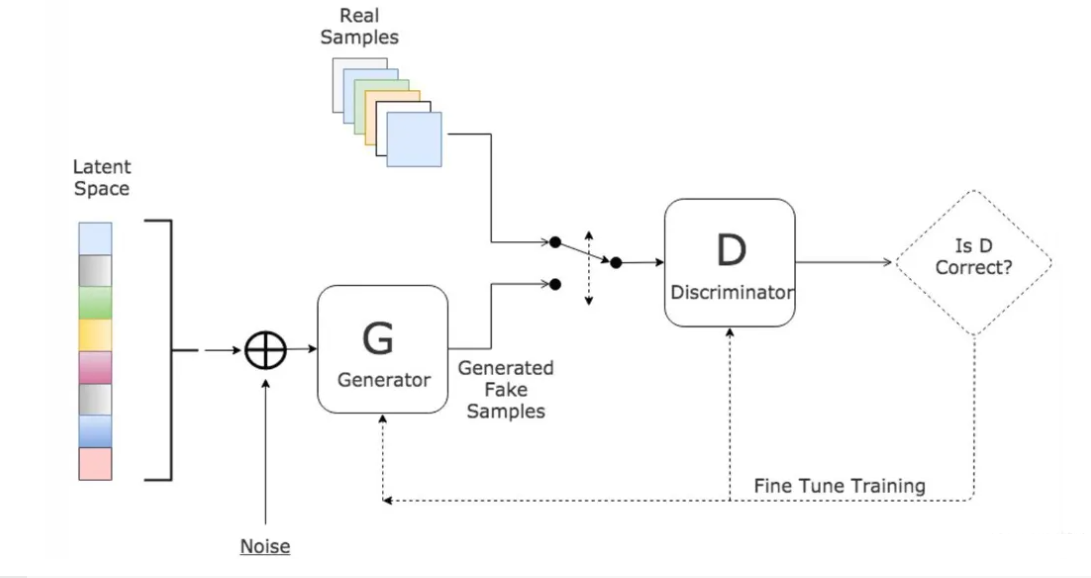

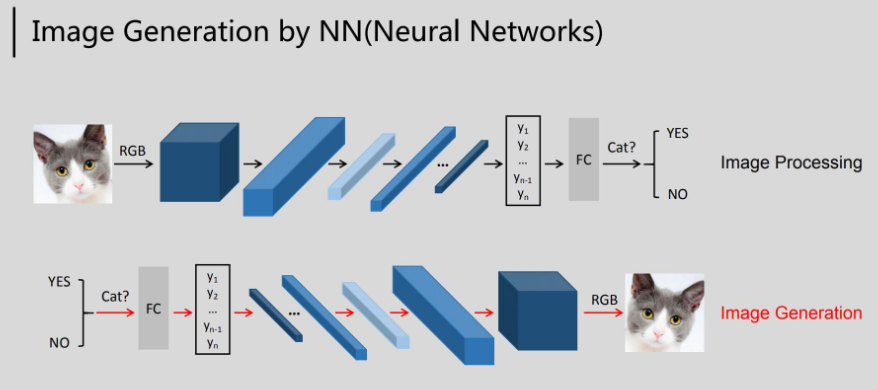

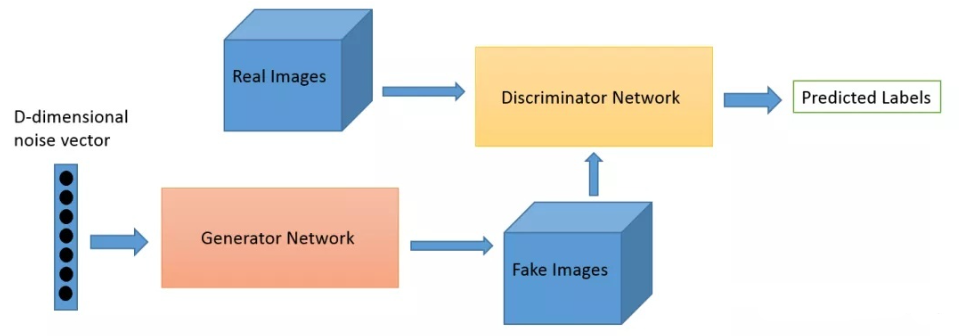

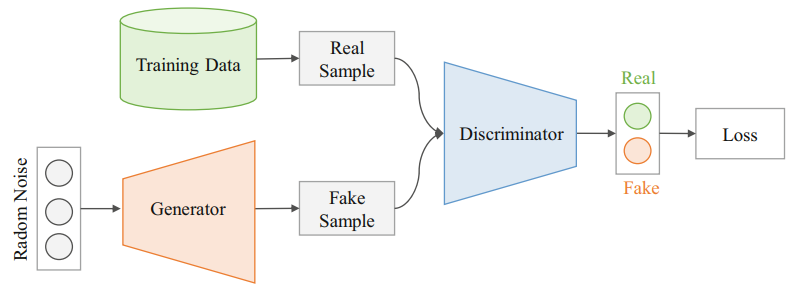

分享生成对抗网络(Generative Adversarial Networks, GANs)是近年来在人工智能生成内容(Artificial Intelligence Generated Content, AIGC)领域取得显著进展的重要技术。GANs通过两个神经网络——生成器(Generator)和判别器(Discriminator)——之间的对抗训练,实现了从噪声中生成高质量、逼真的图像和其他类型的内容。本文将深入探讨GANs在AIGC中的应用,并通过一个代码实例来展示其工作原理。

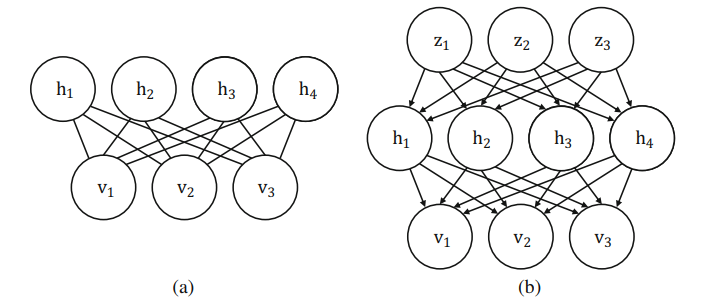

GANs由Goodfellow等人在2014年提出,主要由两个部分组成:

生成器的目标是欺骗判别器,使其认为生成的数据是真实的,而判别器的目标是正确地区分真实数据和生成数据。两个网络通过互相博弈,不断提升自身的能力,最终生成器能够生成高质量的假数据。

GANs在AIGC领域有广泛的应用,包括但不限于以下几个方面:

以下是一个使用GANs生成手写数字(MNIST数据集)的简单代码实例。我们将使用PyTorch来实现这个模型。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torchvision.utils import save_image

# 设置随机种子以确保结果可复现

torch.manual_seed(1)

# 设置训练设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据加载与预处理

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

train_dataset = datasets.MNIST(root='mnist_data', train=True, transform=transform, download=True)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64, shuffle=True)

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Linear(100, 256),

nn.ReLU(True),

nn.Linear(256, 512),

nn.ReLU(True),

nn.Linear(512, 1024),

nn.ReLU(True),

nn.Linear(1024, 784),

nn.Tanh()

)

def forward(self, x):

return self.model(x).view(-1, 1, 28, 28)

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(784, 512),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(512, 256),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(256, 1),

nn.Sigmoid()

)

def forward(self, x):

return self.model(x.view(-1, 784))

generator = Generator().to(device)

discriminator = Discriminator().to(device)

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002)

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002)

criterion = nn.BCELoss()

num_epochs = 100

for epoch in range(num_epochs):

for i, (imgs, _) in enumerate(train_loader):

# 训练判别器

real_imgs = imgs.to(device)

real_labels = torch.ones(imgs.size(0), 1).to(device)

fake_labels = torch.zeros(imgs.size(0), 1).to(device)

optimizer_D.zero_grad()

outputs = discriminator(real_imgs)

d_loss_real = criterion(outputs, real_labels)

z = torch.randn(imgs.size(0), 100).to(device)

fake_imgs = generator(z)

outputs = discriminator(fake_imgs.detach())

d_loss_fake = criterion(outputs, fake_labels)

d_loss = d_loss_real + d_loss_fake

d_loss.backward()

optimizer_D.step()

# 训练生成器

optimizer_G.zero_grad()

outputs = discriminator(fake_imgs)

g_loss = criterion(outputs, real_labels)

g_loss.backward()

optimizer_G.step()

print(f'Epoch [{epoch+1}/{num_epochs}] Loss D: {d_loss.item()}, loss G: {g_loss.item()}')

if (epoch+1) % 10 == 0:

save_image(fake_imgs.data[:25], f'images/{epoch+1}.png', nrow=5, normalize=True)

经过100个epoch的训练,生成器将能够生成逼真的手写数字图像。我们可以通过保存的图像来观察训练进展和最终效果。

除了手写数字的生成,GANs在其他AIGC领域也有诸多应用。以下是几个主要的应用领域和实例:

图像到图像的转换任务旨在将一种图像转换为另一种图像。CycleGAN和pix2pix是两个常见的基于GANs的模型,用于图像到图像的转换。

以下是使用CycleGAN将夏天的风景转换为冬天的风景的示例代码。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torchvision.utils import save_image

from cycle_gan import CycleGAN, Discriminator, Generator # 假设我们有一个cycle_gan.py文件定义了相关类

# 设置随机种子以确保结果可复现

torch.manual_seed(1)

# 设置训练设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据加载与预处理

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(256),

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

summer_dataset = datasets.ImageFolder(root='summer_data', transform=transform)

winter_dataset = datasets.ImageFolder(root='winter_data', transform=transform)

summer_loader = torch.utils.data.DataLoader(summer_dataset, batch_size=1, shuffle=True)

winter_loader = torch.utils.data.DataLoader(winter_dataset, batch_size=1, shuffle=True)

# 初始化CycleGAN模型

G_A2B = Generator().to(device)

G_B2A = Generator().to(device)

D_A = Discriminator().to(device)

D_B = Discriminator().to(device)

cycle_gan = CycleGAN(G_A2B, G_B2A, D_A, D_B, device)

# 设置优化器

optimizer_G = optim.Adam(list(G_A2B.parameters()) + list(G_B2A.parameters()), lr=0.0002, betas=(0.5, 0.999))

optimizer_D_A = optim.Adam(D_A.parameters(), lr=0.0002, betas=(0.5, 0.999))

optimizer_D_B = optim.Adam(D_B.parameters(), lr=0.0002, betas=(0.5, 0.999))

# 训练CycleGAN模型

num_epochs = 200

for epoch in range(num_epochs):

for i, (data_A, data_B) in enumerate(zip(summer_loader, winter_loader)):

real_A = data_A[0].to(device)

real_B = data_B[0].to(device)

loss_G, loss_D_A, loss_D_B = cycle_gan.train_step(real_A, real_B, optimizer_G, optimizer_D_A, optimizer_D_B)

print(f'Epoch [{epoch+1}/{num_epochs}] Loss G: {loss_G.item()}, Loss D_A: {loss_D_A.item()}, Loss D_B: {loss_D_B.item()}')

if (epoch+1) % 10 == 0:

fake_B = G_A2B(real_A)

fake_A = G_B2A(real_B)

save_image(fake_B.data, f'images/fake_B_{epoch+1}.png', normalize=True)

save_image(fake_A.data, f'images/fake_A_{epoch+1}.png', normalize=True)

图像修复是指利用GANs填补图像中的缺失部分,使其看起来自然、逼真。DeepFill是一个用于图像修复的经典模型,利用GANs生成缺失部分的内容。

以下是一个使用DeepFill进行图像修复的简要示例代码。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torchvision.utils import save_image

from deepfill import DeepFillGenerator, DeepFillDiscriminator # 假设我们有一个deepfill.py文件定义了相关类

# 设置随机种子以确保结果可复现

torch.manual_seed(1)

# 设置训练设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据加载与预处理

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(256),

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

dataset = datasets.ImageFolder(root='inpainting_data', transform=transform)

loader = torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=True)

# 初始化DeepFill模型

generator = DeepFillGenerator().to(device)

discriminator = DeepFillDiscriminator().to(device)

# 设置优化器

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002, betas=(0.5, 0.999))

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002, betas=(0.5, 0.999))

# 训练DeepFill模型

num_epochs = 100

for epoch in range(num_epochs):

for i, (imgs, _) in enumerate(loader):

imgs = imgs.to(device)

# 创建遮罩

mask = torch.zeros_like(imgs)

mask[:, :, 100:156, 100:156] = 1

# 生成有缺失的图像

masked_imgs = imgs * (1 - mask)

# 训练判别器

optimizer_D.zero_grad()

real_output = discriminator(imgs)

fake_imgs = generator(masked_imgs)

fake_output = discriminator(fake_imgs.detach())

d_loss_real = criterion(real_output, torch.ones_like(real_output))

d_loss_fake = criterion(fake_output, torch.zeros_like(fake_output))

d_loss = d_loss_real + d_loss_fake

d_loss.backward()

optimizer_D.step()

# 训练生成器

optimizer_G.zero_grad()

fake_output = discriminator(fake_imgs)

g_loss = criterion(fake_output, torch.ones_like(fake_output)) + criterion(fake_imgs, imgs)

g_loss.backward()

optimizer_G.step()

print(f'Epoch [{epoch+1}/{num_epochs}] Loss D: {d_loss.item()}, loss G: {g_loss.item()}')

if (epoch+1) % 10 == 0:

save_image(fake_imgs.data, f'images/repaired_{epoch+1}.png', normalize=True)

尽管GANs主要用于图像生成,但其生成对抗的思想也被引入到文本生成领域。SeqGAN和TextGAN是两种将GANs应用于文本生成的典型模型。

以下是一个使用SeqGAN生成自然语言文本的简要示例代码。

import torch

import torch.nn as nn

import torch.optim as optim

from seqgan import Generator, Discriminator # 假设我们有一个seqgan.py文件定义了相关类

from text_data import get_data_loader # 假设我们有一个text_data.py文件处理文本数据

# 设置随机种子以确保结果可复现

torch.manual_seed(1)

# 设置训练设备

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据加载与预处理

data_loader = get_data_loader('text_data.txt', batch_size=64, seq_len=20)

# 初始化SeqGAN模型

generator = Generator(vocab_size=5000, embedding_dim=32, hidden_dim=64).to(device)

discriminator = Discriminator(vocab_size=5000, embedding_dim=32, hidden_dim=64).to(device)

# 设置优化器

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002)

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002)

# 训练SeqGAN模型

num_epochs = 100

for epoch in range(num_epochs):

for i, (real_data, _) in enumerate(data_loader):

real_data = real_data.to(device)

# 训练判别器

optimizer_D.zero_grad()

real_output = discriminator(real_data)

fake_data = generator.sample(real_data.size(0))

fake_output = discriminator(fake_data.detach())

d_loss_real = criterion(real_output, torch.ones_like(real_output))

d_loss_fake = criterion(fake_output, torch.zeros_like(fake_output))

d_loss = d_loss_real + d_loss_fake

d_loss.backward()

optimizer_D.step()

# 训练生成器

optimizer_G.zero_grad()

fake_output = discriminator(fake_data)

g_loss = criterion(fake_output, torch.ones_like(fake_output))

g_loss.backward()

optimizer_G.step()

print(f'Epoch [{epoch+1}/{num_epochs}] Loss D: {d_loss.item()}, loss G: {g_loss.item()}')

if (epoch+1) % 10 == 0:

fake_text = generator.sample(1)

print(f'Generated Text at Epoch {epoch+1}: {fake_text}')

尽管生成对抗网络(GANs)在AIGC领域取得了巨大的成功,但其应用仍面临一些挑战,如训练不稳定性、模式崩溃(Mode Collapse)、对计算资源的需求等。研究者们提出了多种改进方法,以解决这些问题并提升GANs的性能。以下是一些主要的改进方向和未来展望。

GANs的训练过程通常比较不稳定,容易出现模式崩溃现象,即生成器生成的样本缺乏多样性。为了解决这些问题,研究者提出了多种改进方法:

**Wasserstein GAN (WGAN)**:WGAN引入了Earth-Mover(Wasserstein-1)距离,改进了GANs的损失函数,使得训练过程更加稳定。WGAN还引入了权重剪切(weight clipping)技术,限制了判别器的参数范围。

class WGANGenerator(nn.Module):

def __init__(self):

super(WGANGenerator, self).__init__()

self.model = nn.Sequential(

nn.Linear(100, 256),

nn.ReLU(True),

nn.Linear(256, 512),

nn.ReLU(True),

nn.Linear(512, 1024),

nn.ReLU(True),

nn.Linear(1024, 784),

nn.Tanh()

)

def forward(self, x):

return self.model(x).view(-1, 1, 28, 28)

class WGANDiscriminator(nn.Module):

def __init__(self):

super(WGANDiscriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(784, 512),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(512, 256),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(256, 1)

)

def forward(self, x):

return self.model(x.view(-1, 784))

Gradient Penalty:为进一步改进WGAN的训练稳定性,WGAN-GP(WGAN with Gradient Penalty)引入了梯度惩罚项,替代了权重剪切。这一改进有助于保持判别器的Lipschitz连续性。

def gradient_penalty(discriminator, real_data, fake_data):

alpha = torch.rand(real_data.size(0), 1, 1, 1).to(device)

interpolates = alpha * real_data + ((1 - alpha) * fake_data)

interpolates = interpolates.requires_grad_(True)

d_interpolates = discriminator(interpolates)

fake = torch.ones(d_interpolates.size()).to(device)

gradients = torch.autograd.grad(

outputs=d_interpolates,

inputs=interpolates,

grad_outputs=fake,

create_graph=True,

retain_graph=True,

only_inputs=True

)[0]

gradients = gradients.view(gradients.size(0), -1)

gradient_penalty = ((gradients.norm(2, dim=1) - 1) ** 2).mean()

return gradient_penalty

为了克服模式崩溃,研究者提出了多种方法来增强生成样本的多样性:

Minibatch Discrimination:通过在判别器中加入minibatch discrimination层,使得判别器能够识别同一个minibatch中的样本之间的差异,从而促使生成器生成更多样的样本。

Unrolled GANs:在Unrolled GANs中,生成器的更新考虑了多个判别器更新步骤的影响,减少了模式崩溃现象。

GANs的训练过程通常需要大量的计算资源和时间。为了解决这一问题,研究者提出了以下几种方法:

Progressive GANs:通过逐渐增加生成器和判别器的分辨率来训练模型,可以减少初始阶段的计算量,并提高最终生成图像的质量。

Model Compression:通过剪枝、量化和蒸馏等技术压缩生成器和判别器的模型大小,可以在保证生成质量的同时减少计算资源需求。

未来,GANs在AIGC领域的应用将会更加广泛和深入。以下是一些可能的研究方向和应用场景:

多模态生成:结合图像、文本、音频等多种模态的生成模型,将为多媒体内容生成提供更多可能性。例如,生成带有描述性文本的图像,或生成配有音乐的视频。

个性化内容生成:结合用户偏好和个性化信息,GANs可以生成更符合用户需求的内容。在广告、推荐系统和个性化教育等领域,这一应用将具有巨大的潜力。

生成与强化学习结合:将GANs与强化学习相结合,探索在复杂环境中生成高质量内容的新方法。例如,在游戏开发中,GANs可以用于生成多样化的游戏场景和角色。

医疗和科学领域的应用:GANs在医疗影像生成与修复、药物设计和基因组数据生成等方面将发挥重要作用。高质量的数据生成将有助于科学研究和医疗实践的进步。

生成对抗网络(GANs)在AIGC中的应用展示了其强大的生成能力和广泛的应用前景。通过改进训练稳定性、增强生成样本的多样性和减少计算资源需求,研究者们不断推动GANs技术的发展。未来,随着GANs的进一步发展和应用,我们有理由期待其在更多领域带来创新和突破,推动AIGC的进步。研究者和开发者可以进一步探索GANs的潜力,开发出更加先进和高效的生成模型,为各行各业提供更多的智能生成解决方案。