4,794

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享我正在使用高通的geometric-algebra-transformer, 感谢您出色的 GATr 框架。当我使用 GATr 时,我发现交叉注意期间没有位置编码。请问原因是什么?这是否意味着 GATr 只能支持没有位置编码的交叉注意?

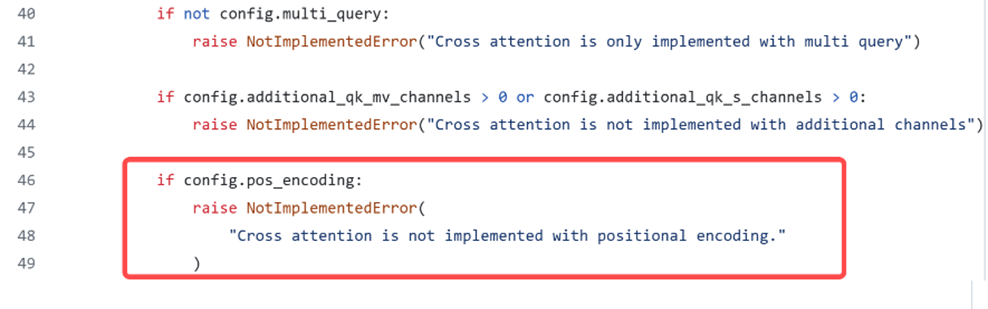

以下是我在 cross_attention.py 中发现的内容,

是的,这并没有实现,因为我们自己也不需要它。请注意,这涉及序列中令牌的位置编码,而不是3D空间中令牌位置的编码。在GATr中,这是通过输入编码完成的。

从SelfAttention中汲取灵感,实现交叉注意的序列位置编码应该很容易。