5,319

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

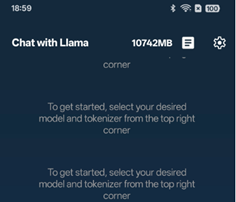

分享部署Llama-3.2-1B推理的时候, 使用QNN的后端时, 运行单击“加载模型”时app应用程序崩溃.

我正在按照 [LlamaDemo 教程]在我的 OnePlus 12 手机(24GB RAM,1TB 存储空间)

上部署 Llama-3.2-1B 模型。但是,我遇到了如图问题:

1). 问题描述

当我单击应用程序中的“加载模型”按钮时,它立即崩溃,没有任何可见的错误消息。

2). 重现步骤

从 [Hugging Face](https://huggingface.co/meta-llama/Llama-3.2-1B/tree/main) 下载原始模型。

使用教程中描述的以下命令转换模型:

python -m examples.models.llama.export_llama --checkpoint "${MODEL_DIR}/consolidated.00.pth" -p "${MODEL_DIR}/params.json" -kv --disable_dynamic_shape --qnn --pt2e_quantize qnn_16a4w -d fp32 --metadata '{"get_bos_id":128000, "get_eos_ids" [128009, 128001]}' --output_name="test.pte"

然后我完全按照教程进行操作

这个错误主要是因为Android SDK版本问题, 如 https://github.com/pytorch/executorch/blob/main/examples/demo-apps/android/LlamaDemo/docs/delegates/qualcomm_README.md 所述。请使用 NDK 版本 26.3.11579264 再试一次。