86

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享【论文标题】De-confounded Data-free Knowledge Distillation for Handling Distribution Shifts

【论文单位】复旦大学

【论文出处】CVPR 2024

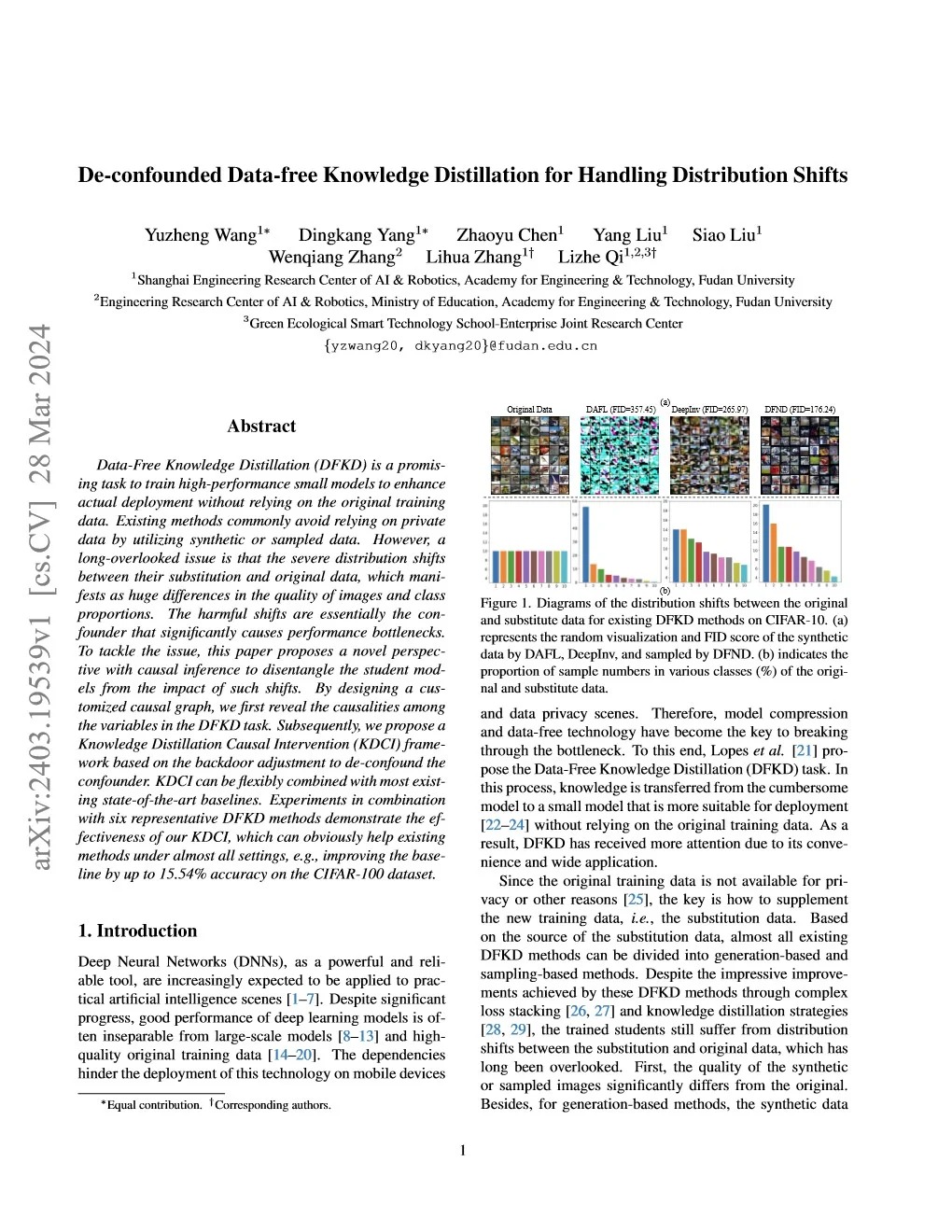

【技术亮点】✨ 本研究提出了一种创新的知识蒸馏方法——知识蒸馏因果干预(KDCI),有效解决了无数据知识蒸馏(DFKD)中的分布偏移问题。

【工作原理】🔍 1. 利用因果推断,定制因果图,揭示DFKD任务变量间的因果关系。 2. 通过后门调整,实现对分布偏移的混杂因素进行干预,提高学生模型的学习质量。

【实验结果】📈 1. 在CIFAR-100数据集上,KDCI结合DeepInv方法,准确率提升15.54%。 2. 在Tiny-ImageNet数据集上,KDCI使Fast方法准确率从28.79%提升至38.23%,DeepInv从20.68%提升至34.84%,DFND从42.64%提升至49.54%。 3. 在ImageNet数据集上,KDCI结合Fast方法,resnet-50到resnet-18模型组合准确率提升4.79%。

【应用场景】🏢 1. 移动设备和数据隐私场景下,模型压缩和数据免费技术是关键。 2. KDCI框架可与现有的DFKD方法灵活结合,提高小模型在实际部署中的性能。

【结语】📝 KDCI为DFKD任务提供了一种有效的因果干预策略,显著提高了小模型在多种数据集上的性能,为模型压缩和数据隐私保护提供了新思路。