86

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享📚论文标题: Collaborative Chain-of-Agents for Parametric-Retrieved Knowledge Synergy

🔍 问题背景:传统RAG方法在处理参数化知识与检索知识的协同上存在局限,检索内容可能误导生成,而生成的某些内容却能引导模型产生更准确输出。

💡 研究动机:为提升LLM在知识密集型任务中的表现,研究团队提出CoCoA框架,旨在显式增强参数化知识与检索知识的协同效应。

🚀 方法简介:CoCoA包含两部分:CoCoA-zero多智能体框架,通过条件知识诱导和推理决策协同内外知识;以及长链训练策略,将多智能体推理轨迹合成长链用于微调LLM。

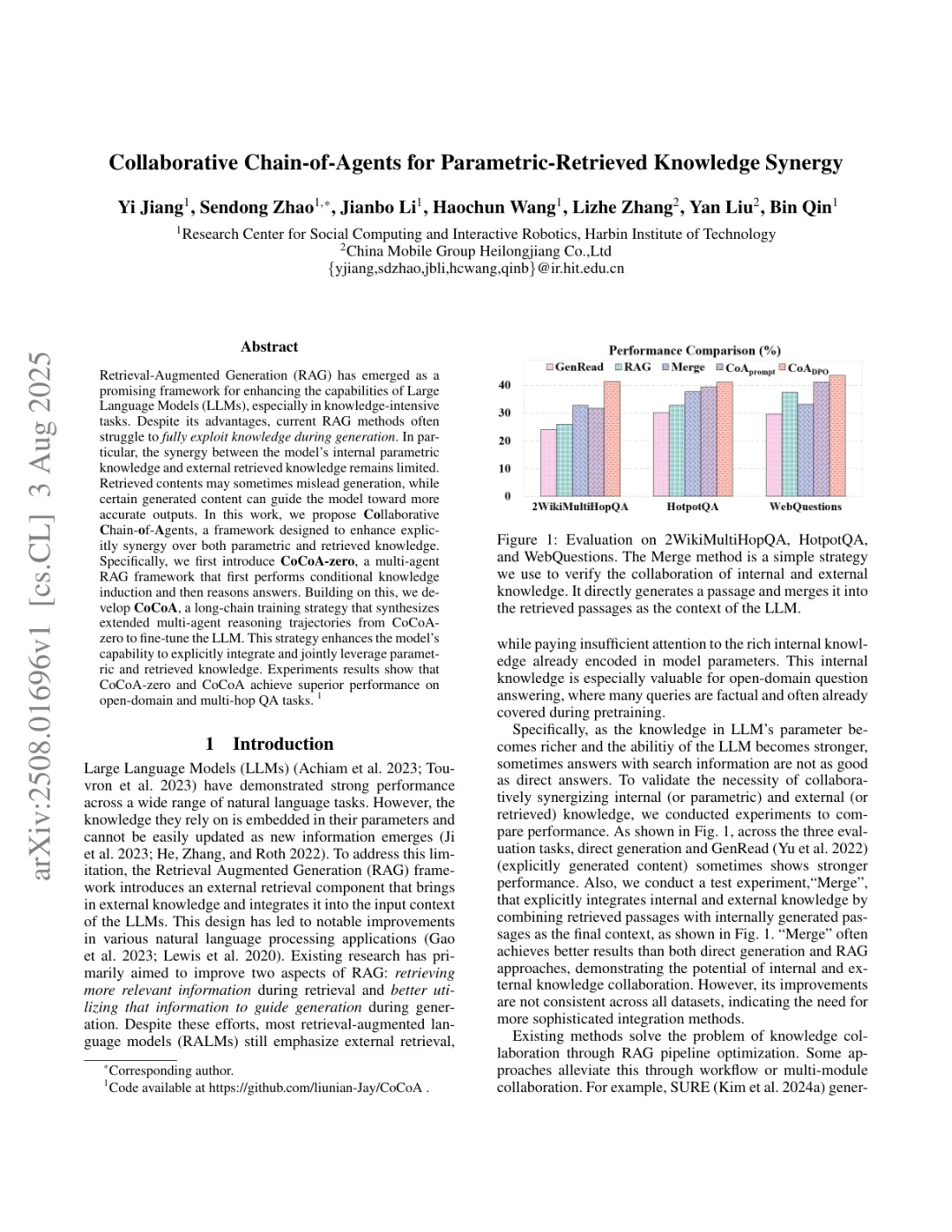

📊 实验设计:在四个问答数据集上进行评估,包括开放域和多跳问答任务。使用LLaMA3.1-8B作为基础模型,通过LoRA进行微调,采用EM和F1作为评估指标。 现有RAG方法往往过于依赖外部检索,而忽视了模型内部丰富的参数化知识。随着LLM能力增强,有时直接生成答案比使用检索信息效果更好。研究团队通过实验验证了内外知识协同的必要性,发现简单合并内外知识的"Merge"方法通常优于纯检索或纯生成方法,但改进效果并不稳定,表明需要更复杂的集成方法。

为解决这一挑战,CoCoA框架采用三个互补智能体:一个用于提取预训练知识,一个用于检索外部数据,第三个则负责综合两者做出最优决策。这不仅实现了内外知识的显式解耦,还为训练提供了协作推理轨迹。在此基础上,CoCoA训练策略将多智能体的协作能力融合到单一模型中,显著提升了知识密集型任务的表现。 实验结果表明,CoCoA在几乎所有数据集上都达到了最先进水平,特别是在2WikiMultiHopQA任务上,EM和F1分别提升了15.2%和15.51%。即使在有限训练数据的情况下,CoCoA在分布外数据集如TriviaQA上也表现良好,展示了其强大的泛化能力。

🌐arXiv ID: arXiv:2508.01696