13,074

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享随着昇腾生态的不断完善,越来越多的 AI 模型开始向MindSpore AI框架迁移。但在实际迁移过程中,开发者常会遇到算子不兼容、权重映射失败、动态图到静态图转换等问题。

本文以一个基于 PyTorch 实现的轻量化分类网络为例,通过分析算子兼容性、修改模型定义、重新导出权重、调试计算图以及在昇腾平台部署推理,展示完整迁移思路与实操经验,帮助开发者快速上手 MindSpore 平台的适配工作。

整个迁移过程分为五步:

MindSpore >= 2.2

msadapter >= 1.0.0

Ascend Toolkit >= 8.0.RC3

PyTorch 版本对齐(建议 1.13~2.1)

2、模型结构分析

使用 torchsummary打印网络结构

记录每层算子类型与输入输出形状

对照 MindSpore 官方算子列表,初步判断兼容性

import msadapter.pytorch as torch

import msadapter.pytorch.nn as nn

class Net(nn.Module):

def __init__(self):

super().__init__()

self.conv = nn.Conv2d(3, 16, 3, stride=1, padding=1)

self.relu = nn.ReLU()

self.fc = nn.Linear(16*32*32, 10)

def forward(self, x):

x = self.relu(self.conv(x))

x = x.view(x.size(0), -1)

return self.fc(x)

使用 python -m ms_adapter.convert model.pt自动转换后,可生成 MindSpore 权重文件。

4、手动修正不兼容算子

若自动转换报错,可在转换日志中查看算子名称,如 aten::flatten、aten::interpolate等。

MindSpore 中可替换为 ops.reshape或 ops.interpolate。例如:

x = ops.reshape(x, (x.shape[0], -1))

5、模型验证与部署

使用 mindspore.load_checkpoint()加载转换后的权重

比较迁移前后模型输出差异

在昇腾 NPU 上执行推理性能测试

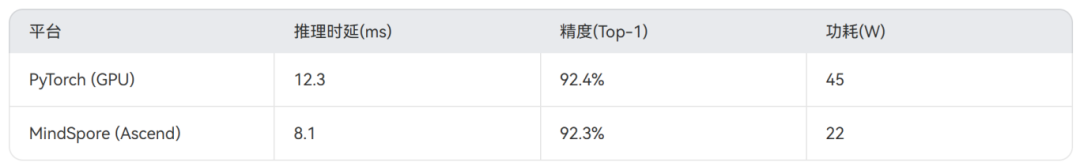

迁移后模型在昇腾上测试结果如下:

迁移后在保持精度的前提下,推理时延降低约 34%,功耗下降近 50%。

通过本次迁移实践,可以得出以下经验:

算子兼容表是迁移核心,建议先对模型结构进行静态分析。

MindSpore 的 msadapter 可显著减少手动改代码量。

充分利用昇腾推理引擎优化策略,如混合精度与图级融合。

迁移过程不止是“跑通”,而是“跑快、跑稳、跑准”。

未来我们将继续探索自定义算子的自动映射机制,让更多 PyTorch 模型“即插即跑”上昇腾。