7,104

社区成员

发帖

发帖 与我相关

与我相关 我的任务

我的任务 分享

分享

python -m qai_hub_models.models.qwen2_5_7b_instruct.export --chipset qualcomm-snapdragon-x-elite --skip-profiling --output-dir genie_bundle

请问通过以上命令执行之后导出的模型context_length只有4096,如果要支持128K的上下文应该如何导出。

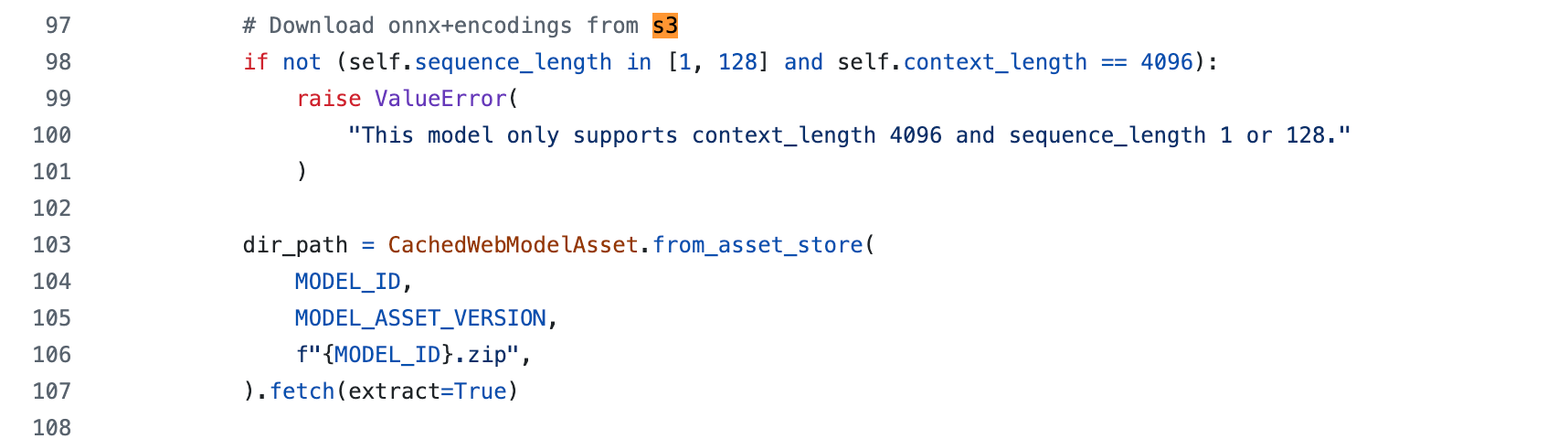

看转换代码已经限制了:https://github.com/quic/ai-hub-models/blob/main/qai_hub_models/models/qwen2_5_7b_instruct/model.py

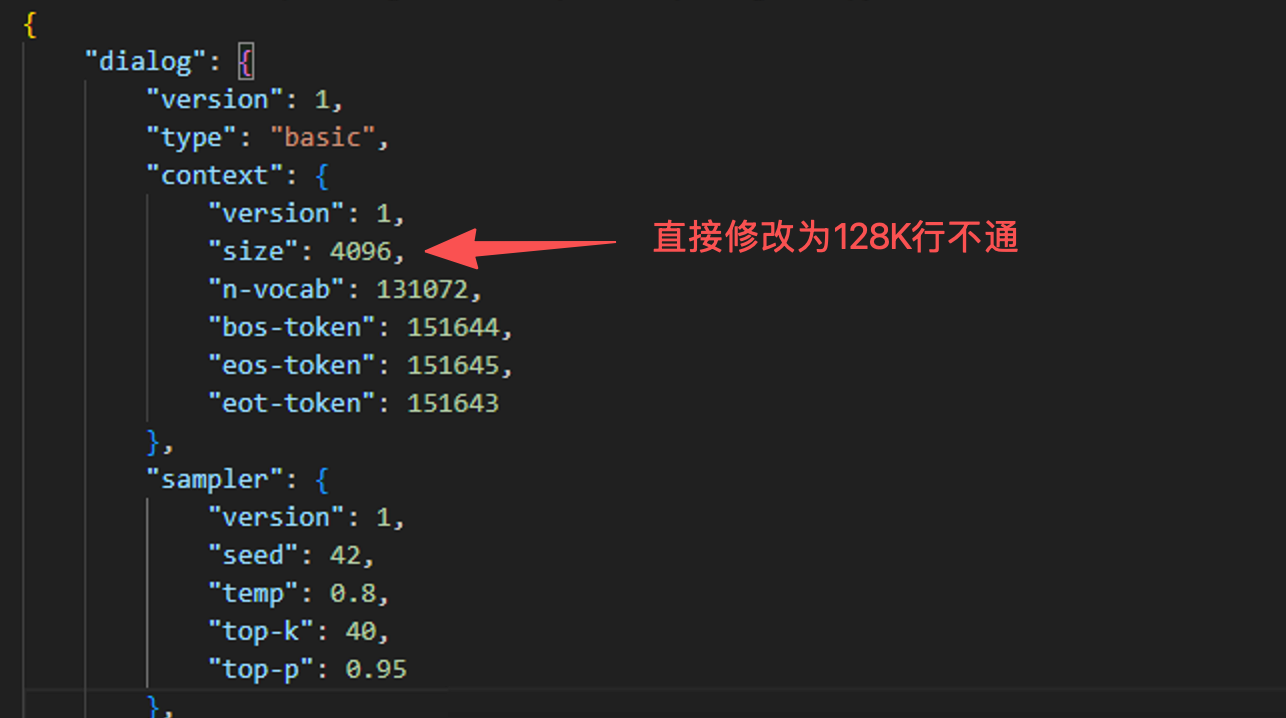

直接修改config.json 中的size无法运行,使用GenieAPIService.exe运行不了

端侧部署的模型使用4k 上下文的kv-cache 优化推理加速,是固定的,4K 上下文满足一般chat应用场景。

长上下文会引起内存过量使用以及推理时长超长; 超长上下文不支持。