千寻智能Spirit AI寻找AI Infra方向顶尖人才

社区首页 (3653)

请编写您的帖子内容

社区频道(7)

显示侧栏

卡片版式

全部

CUDA高性能计算讨论

CUDA on Linux

CUDA on Win

博文收录

Ada助手

问答

最新发布

最新回复

标题

阅读量

内容评分

精选

207

评分

回复

千寻智能Spirit AI寻找AI Infra方向顶尖人才

具身智能头部公司千寻智能Spirit AI寻找AI Infra方向的优秀人才, 欢迎各位感兴趣的朋友联系~ 简历直达CEO~ 关于千寻智能Spirit AI:https://www.spirit-ai.com/ 欢迎私戳~

复制链接 扫一扫

分享

189

评分

1

cuda流并行求助贴

我的核函数数据量比较小,占不满4090的计算资源,而且还需要对计算结果进行回传,要进行很多次。 我使用流进行核函数并行,让数据计算与传输同时进行达到隐藏延迟的目的。 因本人比较菜,遇到如图问题,一开始并行的很好,但是为什么后半段效果就完全没有呢。而且

复制链接 扫一扫

分享

222

评分

回复

神秘的cuda,将函数砍掉一半,运算速度反而下降一倍.....

神秘的cuda,将函数砍掉一半,运算速度反而下降一倍..................

复制链接 扫一扫

分享

cuda线程能挂起吗?

如题:cuda线程能挂起吗?

...全文

194

评分

回复

cuda线程能挂起吗?

如题:cuda线程能挂起吗?

复制链接 扫一扫

分享

207

评分

回复

cuda多流,但仍然串行的问题?

// 如题: vs2022, cuda 12.6 __device__ volatile int a = 0; __device__ volatile int b = 0; __global__ void ga()//使用流1 { a = 1; f

复制链接 扫一扫

分享

264

评分

回复

请教一个cuda动态并行,随机卡死的问题

// 源代码如下, VS2022, cuda 12.6, __global__ void SetBool(volatile int* b) { if (ptrdiff_t(b) > 100) * b = 1; else __nanosleep(1)

复制链接 扫一扫

分享

345

评分

回复

请教:cuda的动态并行库,与c++ 的iomanip库,为什么在特殊情况下,存在冲突?

// vs2022, c++20, cuda12.6, x64, DEBUG // // 请教下,为什么在自建lib项目中使用了<iomanip>, // 而如果在cuda动态并行项目中,使用了此lib, 但不主动使用<iomanip> // 那么

复制链接 扫一扫

分享

357

评分

回复

cuda中的结构体数据传递问题

结构体中有数组,结构体传入GPU后在核函数中分配了数组内存(new),给数组传入了数据 怎么把数据带回CPU端

复制链接 扫一扫

分享

711

评分

1

急需cuda大佬!急需cuda大佬!

兼职职位、时间自由、地点自由,不耽误个人事宜。 根据要求完成CUDA相关任务 薪资:200-300/h,200-800/次(根据难度上下浮动) 招聘要求: 1.国内985/211/qs前300院校本科大三以上在读或毕业。 2.四级/六级500左右/雅

复制链接 扫一扫

分享

718

评分

1

要如何提高CUDA内核运行速度?

我的内核函数执行较慢,于是我想通过调试来判断是什么因素影响了CUDA内核的执行速度。 我从后向前不停地注释代码,然后反复测试执行时间,发现当代码注释到某一段后,其整体运算时间突然由25s降低到了9s。然后发生跳变的那条注释代码是一条非常普通的运算,不

复制链接 扫一扫

分享

832

评分

回复

cuda 设备内memcpy速度太慢

如果直接写核函数实现显存到显存的拷贝 __global__ void NavieCpy(cufftComplex* src, cufftComplex* des) { int id = blockIdx.x + threadIdx.x * gri

复制链接 扫一扫

分享

892

评分

2

CUDA的纹理内存的大小限制该如何理解?

CUDA Texture memory的大小限制该如何理解

复制链接 扫一扫

分享

875

评分

回复

想咨询下博世拧紧控制软件BS350应该怎么安装

在博世官网下载的BS350软件,可是没有办法安装 安装时候弹出未安装过以前的软件 可是在官网和其他网站上寻找了大半天也没有低版本的软件下载 有没有大佬可以解惑,帮个忙

复制链接 扫一扫

分享

我想问一下,我自己写cuda跑1000轮训练,一开始还比较快,一百轮之后每轮的耗时会越来越慢。有人遇到类似的问题了吗?之前看到都是说GPU训练需要预热,应该会越来越快,为什么会越来越慢呢?内存监控也没

703

评分

回复

我想问一下,我自己写cuda跑1000轮训练,一开始还比较快,一百轮之后每轮的耗时会越来越慢。有人遇到类似的问题了吗?之前看到都是说GPU训练需要预热,应该会越来越快,为什么会越来越慢呢?内存监控也没

我想问一下,我自己写cuda跑1000轮训练,一开始还比较快,一百轮之后每轮的耗时会越来越慢。有人遇到类似的问题了吗?之前看到都是说GPU训练需要预热,应该会越来越快,为什么会越来越慢呢?内存监控也没有出现异常的地方

复制链接 扫一扫

分享

650

评分

1

在核函数中定义的局部变量,打印其地址都是相同的?

代码如下: 输出结果: 请教一下啊,难道每个线程都访问相同的显存地址,并给地址赋值,这不会数据冲突吗?

复制链接 扫一扫

分享

1117

评分

回复

cuda内存拷贝失败

前段时间因为工作需要写了一个png图片处理的功能,由于需要逐像素的处理,所有上了cuda。之前运行一直都是正常的,处理过的最大图像最大差不多是8k。今天突然接到反馈说图像处理失败了,排查了一下午,结果发现问题本身非常奇怪。 总体而言就是只对特定数据量

复制链接 扫一扫

分享

759

评分

回复

关于CUDA进行FFT的速度问题

我最近在写代码的时候用到了FFT,在matlab中一个2097152点的数据进行FFT用了0.15S,在cuda中用CUFFT库中的C2C,用了0.14S,只相差了0.1S,请问本来就是这样子的吗?可是我在网上查资料发现CUFFT按理说应该提速100

复制链接 扫一扫

分享

722

评分

回复

洗牌束指令归约与使用共享内存归约谁更快?

我做了一个测试,分别用洗牌束指令与共享内存进行归约计算,一个block内,循环做100000次,结果如下: 为什么洗牌束指令的速度不如shared memory?按照cuda操作指南的描述,洗牌束指令应该更快的,是程序有问题么?

复制链接 扫一扫

分享

775

评分

1

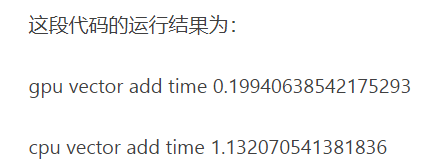

初次尝试GUP运行python,测试代码时发现结果不好

使用的时pycharm,显卡为nvidia 2060 运行网上别人写的测试代码,据他所说gpu运行速度应当比cpu快很多 结果我自己运行时刚好相反,我是gpu设置出错了,还是代码有问题?请大佬指点!!! from numba import cuda

复制链接 扫一扫

分享

为您搜索到以下结果: